Nadchodzi kolejny krok w technologii sztucznej inteligencji.

- Lama 2 pozwoli ci zbudować własne złożone modele AI.

- Będziesz mógł dostroić i wdrożyć modele Llama 2 o parametrach 7B, 13B i 70B.

- A jeśli jesteś programistą korzystającym z systemu Windows, czeka Cię niespodzianka.

Na Microsoft Inspire 2023 Konferencja, wydarzyło się coś ekscytującego. Microsoft połączył siły z Meta stworzyć partnerstwo AI z Llama 2.

Dzisiaj na konferencji Microsoft Inspire firmy Meta i Microsoft ogłosiły wsparcie dla rodziny dużych modeli językowych (LLM) Llama 2 na platformach Azure i Windows. Llama 2 została zaprojektowana, aby umożliwić programistom i organizacjom tworzenie generatywnych narzędzi i środowisk opartych na sztucznej inteligencji. Meta i Microsoft podzielają zaangażowanie w demokratyzację sztucznej inteligencji i jej korzyści i cieszymy się, że Meta przyjmuje otwarte podejście do Llama 2. Oferujemy programistom wybór typów modeli, na których bazują, wspierając modele otwarte i graniczne, i jesteśmy zachwyceni być preferowanym partnerem Meta, gdy po raz pierwszy wypuszczają nową wersję Llama 2 dla klientów komercyjnych czas.

Microsoftu

Ma to sens, ponieważ pierwszy dzień konferencji poświęcony był sztucznej inteligencji. Microsoft ogłosił wiele rzeczy związanych z AI oprócz partnerstwa Meta AI. Usługa Azure OpenAI jest teraz dostępny w Azji po niedawnym wydaniu w Ameryce Północnej i Europie.

Czat Bing Enterprise ogłoszono również i jest to wersja Bing AI, ale do pracy. Narzędzie jest teraz dostępne w wersji zapoznawczej. I, Program partnerski Microsoft Cloud otrzymuje aktualizację AI. Możesz teraz używać sztucznej inteligencji do opracowywania biznesplanu lub strategii marketingowej, jednocześnie wykorzystując ją do budowania portfolio.

Więc jeśli chodzi o sztuczną inteligencję, Microsoft jest w czołówce od samego początku. A teraz partnerstwo giganta technologicznego z Redmond z Meta może być kolejną wielką rzeczą w świecie sztucznej inteligencji.

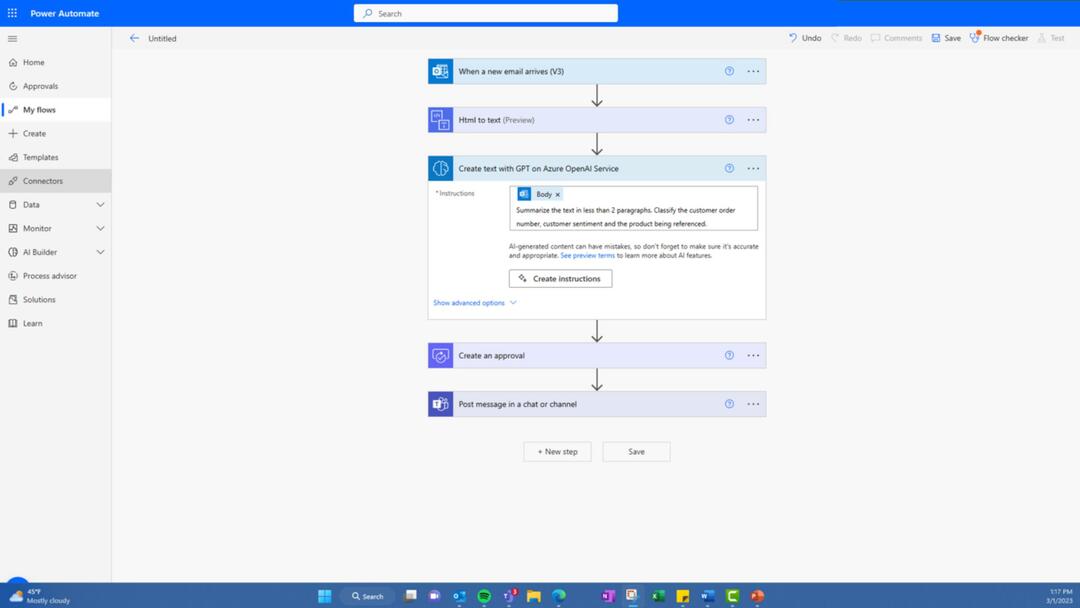

Jak wspomniano wcześniej, Llama 2 umożliwia programistom i organizacjom tworzenie generatywnych narzędzi i doświadczeń AI.

Będziesz mógł łatwo i bezpieczniej dostosować i wdrożyć modele Llama 2 z parametrami 7B, 13B i 70B na platformie Azure.

Ponadto musisz wiedzieć, że Lama zostanie zoptymalizowana do lokalnego działania w systemie Windows. A jeśli jesteś programistą pracującym w systemie Windows, będziesz mógł używać Lamy, kierując reklamy na dostawcę wykonania DirectML za pośrednictwem środowiska wykonawczego ONNX.

Programiści Windows będą mogli również łatwo tworzyć nowe doświadczenia za pomocą Llama 2, do którego można uzyskać dostęp za pośrednictwem GitHub Repo. Dzięki podsystemowi Windows dla systemu Linux i wydajnym procesorom graficznym możesz dostosować LLM do swoich konkretnych potrzeb bezpośrednio na ich komputerach z systemem Windows.

Co sądzisz o tym partnerstwie? Daj nam znać w sekcji komentarzy poniżej.