- Den nye supercomputer, der er udviklet sammen med OpenAI, er et enkelt system med mere end 285.000 CPU-kerner, 10.000 GPU'er og 400 gigabit per sekund netværksforbindelse til hver GPU-server.

- Microsoft skriver, at compareret med andre maskiner, der er anført på TOP500 supercomputere i verden er deres system blandt de fem bedste.

- Årets Build-begivenhed var fuld af overraskelser. Tjek hvad der er nyhederne fra vores Microsoft Build 2020-sektion.

- Det Microsoft News Hub er, hvor du altid vil finde de vigtigste historier om virksomheden.

Partnerskabet, som Microsoft annoncerede sidste år med den kunstige intelligensstart OpenAI, har været frugtbart for at sige mindst fordi de ved dette års Build-begivenhed meddelte, at de har bygget den femte mest magtfulde AI-computer i verden.

Hvad er de tekniske specifikationer for Microsoft AI supercomputer?

Supercomputeren udviklet sammen med OpenAI er et enkelt system med mere end 285.000 CPU-kerner, 10.000 GPU'er og 400 gigabit per sekund netværksforbindelse til hver GPU-server.

Microsoft skriver i et blogindlæg at compareret med andre maskiner, der er anført på TOP500 supercomputere i verden, deres system er blandt de fem bedste.

Dette handler om at være i stand til at gøre hundrede spændende ting i naturlig sprogbehandling på én gang og hundrede spændende ting i computersyn, og når du begynder at se kombinationer af disse perceptuelle domæner, får du nye applikationer, som det er svært at forestille dig lige nu.

, sagde OpenAI CEO Sam Altman.

Hvad skal Microsoft AI supercomputer bruges til?

Microsoft meddelte, at det snart ville begynde at tilbyde sine Microsoft Turing-modeller i open source og opskrifter til træning af dem i Azure Machine Learning.

Hvis du er udvikler, giver dette dig adgang til den samme familie af sprogmodeller, som Microsoft bruger til at forbedre sprogforståelsen på tværs af alle sine produkter.

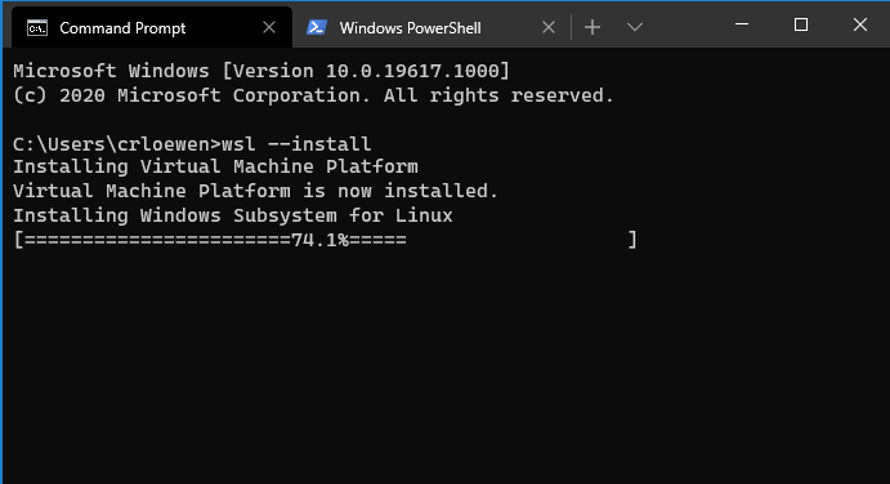

De vil også bruge supercomputeren med den nye version af DeepSpeed.

For dem der ikke er fortrolige med det, er DeepSpeed et open-source deep-learning bibliotek til PyTorch, der reducerer mængden af computerkraft, der kræves til stor distribueret modeluddannelse.

Opdateringen er meget bedre end den version, der blev frigivet for tre måneder siden. Nu tillader det træningsmodeller mere end 15 gange større og 10 gange hurtigere end at gøre det samme uden DeepSpeed på den samme infrastruktur.