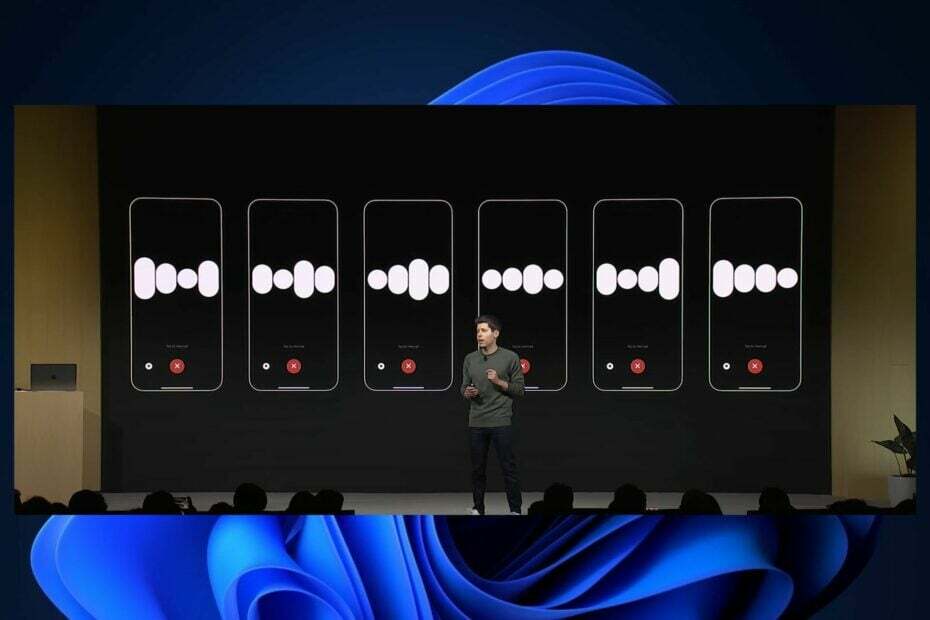

Rozszerzony kontekst jest porównywalny z 300-stronicową książką.

OpenAI właśnie ogłosiło GPT-4 Turbo, po raz pierwszy w historii Wydarzenie OpenAI DevDay. GPT-4 Turbo zwiększa długość kontekstu do 128 000 tokenów.

Firma twierdzi, że 128 000 tokenów można porównać do 300-stronicowej książki, dzięki czemu użytkownicy będą mieli teraz znacznie więcej miejsca na interakcję z ChatGPT w ramach jednej dyskusji.

Chociaż nieograniczona długość kontekstu jest wciąż w fazie rozwoju, jak omówiliśmy historię na początku tego roku, gdzie Microsoft próbuje to osiągnąć, GPT-4 wydłużając długość kontekstu do takiego stopnia, że będzie więcej niż użyteczne.

GPT-4 Turbo ma większe możliwości i posiada wiedzę o wydarzeniach na świecie do kwietnia 2023 roku. Ma okno kontekstowe o pojemności 128 tys., więc w jednym wierszu może zmieścić równowartość ponad 300 stron tekstu. Zoptymalizowaliśmy także jego wydajność, dzięki czemu jesteśmy w stanie zaoferować GPT-4 Turbo w cenie 3x taniej cena za tokeny wejściowe i 2x niższa cena za tokeny wyjściowe w porównaniu do GPT-4.

OpenAI

GPT-4 Turbo jest obecnie dostępny w trybie podglądu, ale OpenAI obiecuje wypuścić jego stabilną wersję w nadchodzących tygodniach.

GPT-4 Turbo: Oto wszystko, co musisz o tym wiedzieć

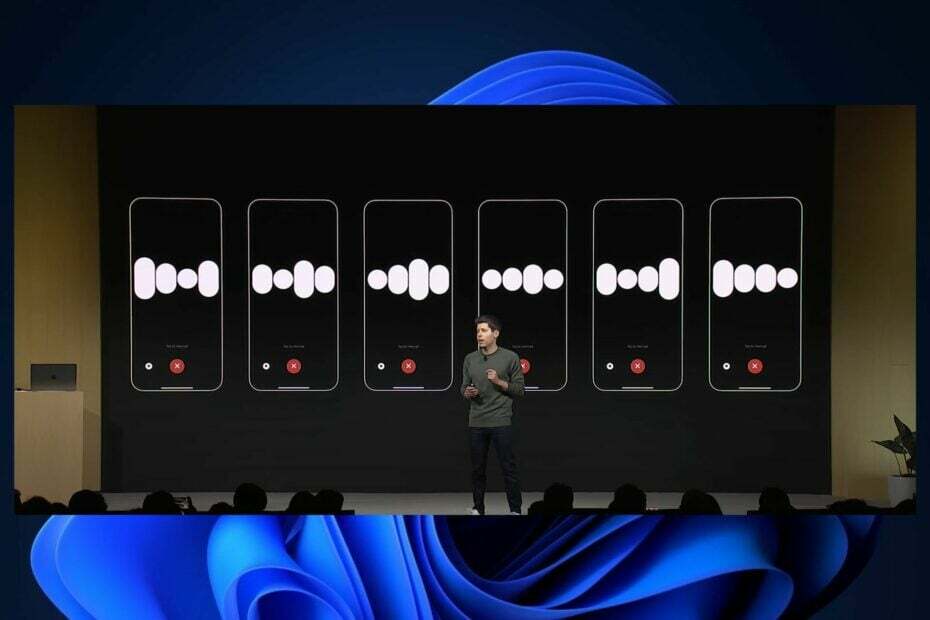

GPT-4 Turbo będzie miał ulepszone instrukcje, a według OpenAI ta wersja GPT będzie również zawierać nowe ulepszenia w zakresie wywoływania funkcji.

Dzisiaj udostępniamy kilka ulepszeń, w tym możliwość wywoływania wielu funkcji w jednej wiadomości: użytkownicy mogą wysłać jedną wiadomość żądanie wielu działań, takich jak „otwarcie okna samochodu i wyłączenie klimatyzacji”, co wcześniej wymagało wielu podróży w obie strony z Model (Ucz się więcej). Poprawiamy także dokładność wywoływania funkcji: GPT-4 Turbo z większym prawdopodobieństwem zwróci właściwe parametry funkcji.

OpenAI

Model będzie także zdolny do generowania powtarzalnych wyników, co według własnych słów OpenAI jest nieocenione dla programistów.

Ta funkcja beta jest przydatna w przypadkach użycia, takich jak powtarzanie żądań debugowania, pisanie bardziej kompleksowych testów jednostkowych i ogólnie posiadanie wyższego stopnia kontroli nad zachowaniem modelu. W OpenAI używamy tej funkcji wewnętrznie do naszych własnych testów jednostkowych i uznaliśmy ją za bezcenną.

OpenAI

Wraz z GPT-4 Turbo nadchodzi także GPT 3.5 Turbo, który zostanie wydany z wieloma nowymi funkcjami.

Nowa wersja 3.5 Turbo obsługuje ulepszone wykonywanie instrukcji, tryb JSON i równoległe wywoływanie funkcji. Na przykład nasze wewnętrzne oceny wykazują 38% poprawę formatu po zadaniach takich jak generowanie JSON, XML i YAML. Programiści mogą uzyskać dostęp do tego nowego modelu, wywołując gpt-3.5-turbo-1106 w interfejsie API. Aplikacje korzystające z nazwy gpt-3.5-turbo zostaną automatycznie zaktualizowane do nowego modelu 11 grudnia. Starsze modele będą nadal dostępne po przekazaniu gpt-3.5-turbo-0613 w interfejsie API do 13 czerwca 2024 r.

OpenAI

Jakie są Twoje przemyślenia na temat nowego GPT-4 Turbo?