- Tensor Processing Units to wyspecjalizowane układy scalone (IC) do określonych zastosowań, przydatne w przyspieszaniu obciążeń ML.

- Podczas gdy NVIDIA koncentruje swoje wysiłki na procesorach graficznych, Google jest pionierem technologii TPU i jest liderem w tym dziale.

- TPU pozwala na znacznie obniżone koszty szkolenia, które przewyższają początkowe, dodatkowe wydatki na programowanie.

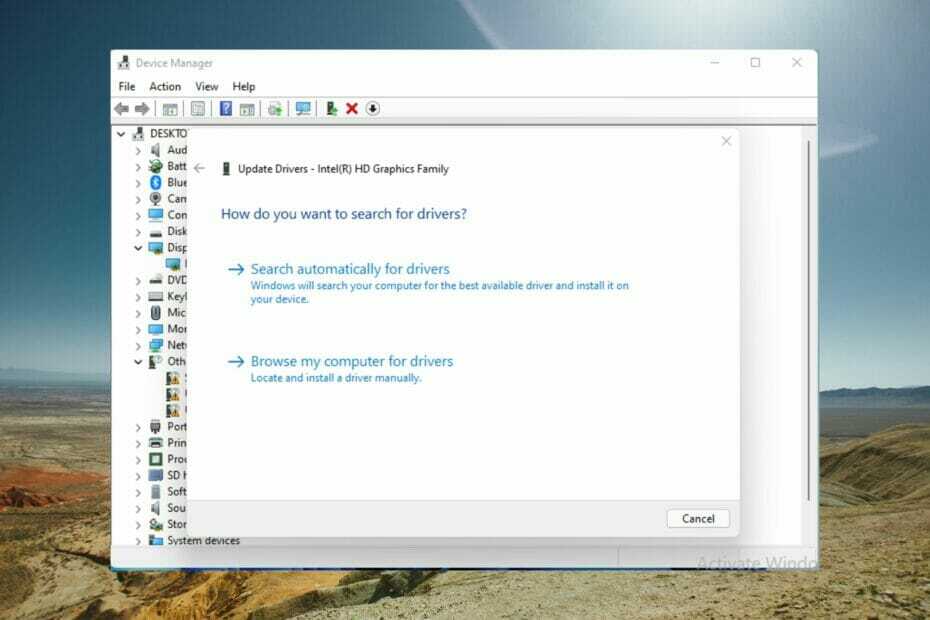

XZAINSTALUJ KLIKAJĄC POBIERZ PLIK

To oprogramowanie będzie utrzymywać Twoje sterowniki w stanie gotowości, chroniąc w ten sposób przed typowymi błędami komputera i awariami sprzętu. Sprawdź teraz wszystkie sterowniki w 3 prostych krokach:

- Pobierz poprawkę sterownika (zweryfikowany plik do pobrania).

- Kliknij Rozpocznij skanowanie znaleźć wszystkie problematyczne sterowniki.

- Kliknij Zaktualizuj sterowniki aby uzyskać nowe wersje i uniknąć nieprawidłowego działania systemu.

- DriverFix został pobrany przez 0 czytelników w tym miesiącu.

W tym artykule zrobimy porównanie TPU do. Porównanie GPU. Ale zanim się w to zagłębimy, oto co musisz wiedzieć.

Uczenie maszynowe i sztuczna inteligencja przyspieszyły rozwój inteligentnych aplikacji. W tym celu firmy półprzewodnikowe nieustannie tworzą akceleratory i procesory, w tym TPU i CPU, do obsługi bardziej złożonych aplikacji.

Niektórzy użytkownicy mieli problemy ze zrozumieniem, kiedy zaleca się używanie TPU, a kiedy używać GPU do zadań komputerowych.

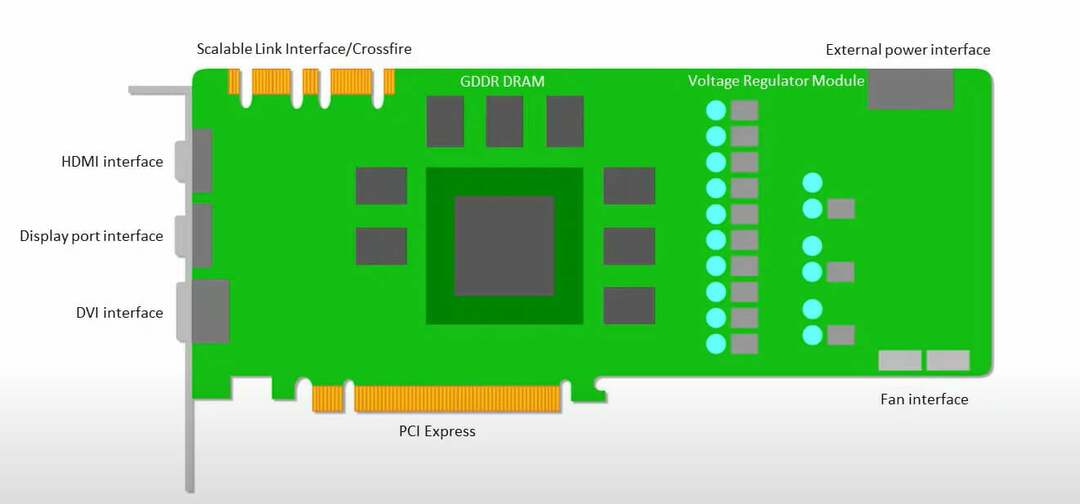

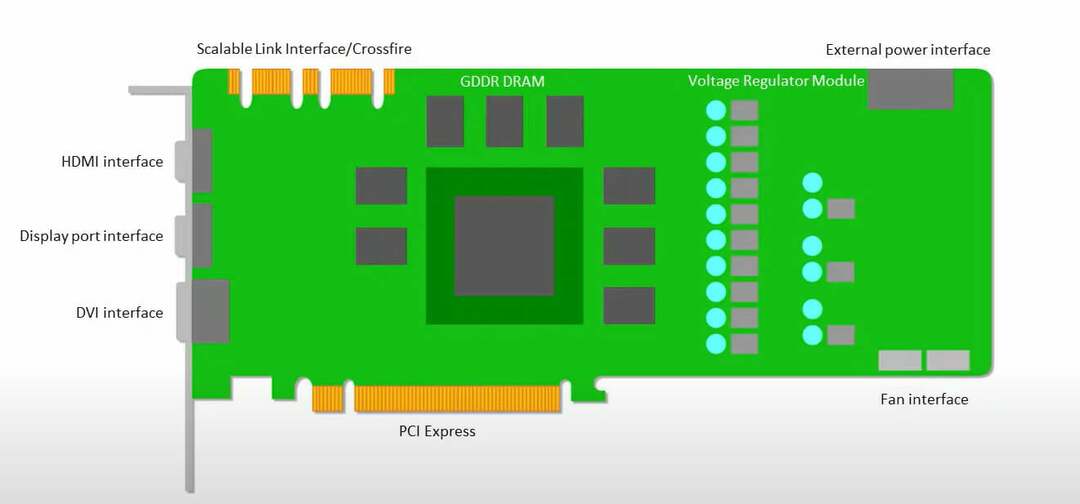

Procesor GPU, znany również jako jednostka przetwarzania graficznego, to karta graficzna komputera, która zapewnia wizualne i wciągające wrażenia z komputera. Na przykład możesz wykonać proste kroki, jeśli Komputer nie wykrywa GPU.

Aby lepiej zrozumieć te okoliczności, musimy również wyjaśnić, czym jest TPU i jak wypada w porównaniu z GPU.

Co to jest TPU?

TPU lub jednostki przetwarzania tensorów to wyspecjalizowane układy scalone (IC) do określonych zastosowań, znane również jako ASIC (układy scalone specyficzne dla aplikacji). Firma Google stworzyła TPU od podstaw, zaczynając z nich korzystać w 2015 roku, a publicznie udostępniła je w 2018 roku.

TPU są oferowane jako mniejsze wersje chipów lub w chmurze. Aby przyspieszyć uczenie maszynowe dla sieci neuronowej za pomocą oprogramowania TensorFlow, jednostki TPU w chmurze rozwiązują skomplikowane operacje na macierzach i wektorach z niewiarygodną szybkością.

Dzięki TensorFlow zespół Google Brain opracował platformę uczenia maszynowego typu open source, dzięki której badacze, programiści i przedsiębiorstwa mogą tworzyć i obsługiwać modele sztucznej inteligencji przy użyciu sprzętu Cloud TPU.

Podczas uczenia złożonych i niezawodnych modeli sieci neuronowych TPU skraca czas do osiągnięcia wartości dokładności. Oznacza to, że modele uczenia głębokiego, których trenowanie przy użyciu procesorów graficznych mogło zająć tygodnie, zajmują mniej niż ułamek tego czasu.

Czy TPU to to samo co GPU?

Są bardzo wyraźne pod względem architektonicznym. Jednostka przetwarzania graficznego to procesor sam w sobie, aczkolwiek taki, który jest potokowy w kierunku programowania numerycznego zwektoryzowanego. W efekcie GPU to kolejna generacja superkomputerów Cray.

TPU to koprocesory, które nie wykonują samodzielnie instrukcji; kod jest wykonywany na procesorach, co zasila TPU przepływ małych operacji.

Kiedy powinienem używać TPU?

TPU w chmurze dostosowujemy do konkretnych aplikacji. W niektórych przypadkach możesz preferować wykonywanie zadań uczenia maszynowego przy użyciu procesorów graficznych lub procesorów. Ogólnie rzecz biorąc, poniższe zasady mogą pomóc w ocenie, czy TPU jest najlepszą opcją dla Twojego obciążenia:

- W modelach dominują obliczenia macierzowe

- W głównej pętli treningowej modelu nie ma niestandardowych operacji TensorFlow

- To modelki, które przechodzą tygodnie lub miesiące szkolenia

- Są to masywne modele, które mają obszerne, efektywne wielkości partii.

Przejdźmy teraz do bezpośredniego TPU vs. Porównanie GPU.

Jakie są różnice między GPU a TPU?

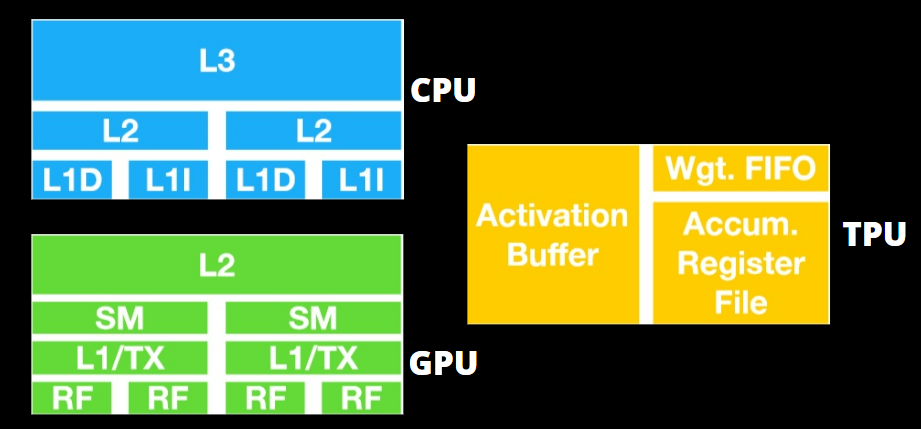

TPU a Architektura GPU

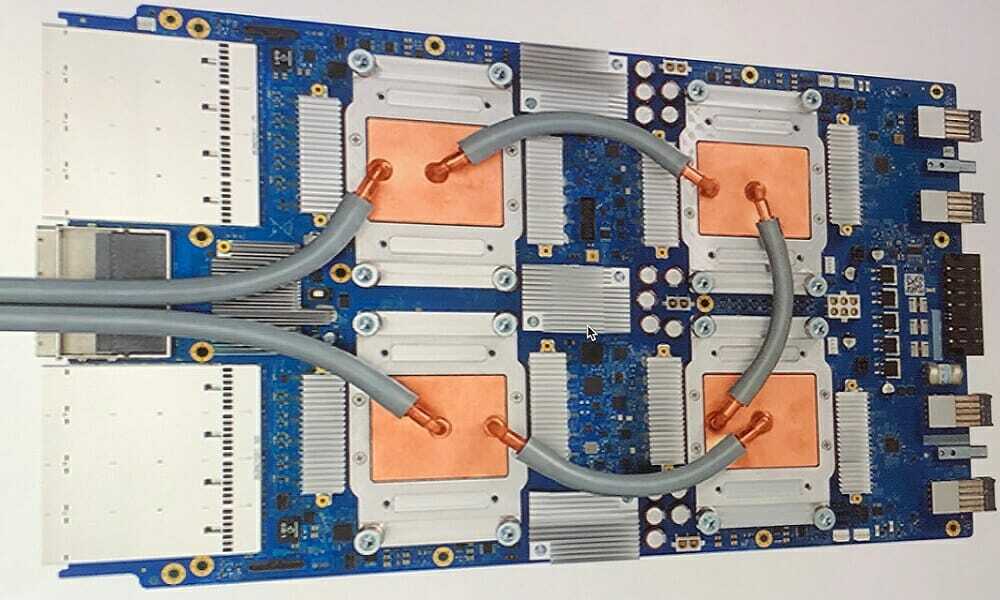

TPU nie jest wysoce skomplikowanym sprzętem i przypomina silnik przetwarzania sygnału dla aplikacji radarowych, a nie tradycyjną architekturę opartą na X86.

Pomimo wielu podziałów mnożenia macierzy, jest mniej GPU, a bardziej koprocesorem; wykonuje jedynie polecenia otrzymane od hosta.

Ponieważ istnieje tak wiele wag do wprowadzenia do składnika mnożenia macierzy, pamięć DRAM TPU działa równolegle jako pojedyncza jednostka.

Ponadto, ponieważ jednostki TPU mogą wykonywać tylko operacje na macierzach, płyty TPU są połączone z systemami hosta opartymi na procesorach, aby wykonywać zadania, z którymi nie mogą sobie poradzić jednostki TPU.

Komputery-hosty odpowiadają za dostarczanie danych do TPU, wstępne przetwarzanie i pobieranie szczegółów z Cloud Storage.

Procesory graficzne są bardziej zainteresowane zastosowaniem dostępnych rdzeni do pracy niż dostępem do pamięci podręcznej o niskim opóźnieniu.

Wiele komputerów PC (klastrów procesorów) z wieloma modułami SM (wieloprocesorami strumieniowymi) staje się pojedynczym gadżetem GPU, z warstwami pamięci podręcznej pierwszej warstwy instrukcji i towarzyszącymi rdzeniami umieszczonymi w każdym module SM.

Przed wydobyciem danych z globalnej pamięci GDDR-5, jeden moduł SM zazwyczaj korzysta ze wspólnej warstwy dwóch pamięci podręcznych i dedykowanej warstwy jednej pamięci podręcznej. Architektura GPU jest odporna na opóźnienia pamięci.

GPU działa z minimalną liczbą poziomów pamięci podręcznej. Jednak ponieważ procesor graficzny ma więcej tranzystorów przeznaczonych do przetwarzania, mniej przejmuje się czasem dostępu do danych w pamięci.

Możliwe opóźnienie dostępu do pamięci jest ukryte, ponieważ GPU zajmuje się odpowiednimi obliczeniami.

TPU a Szybkość GPU

To oryginalne wnioskowanie ukierunkowane na generację TPU, które używa wyuczonego modelu, a nie wytrenowanego.

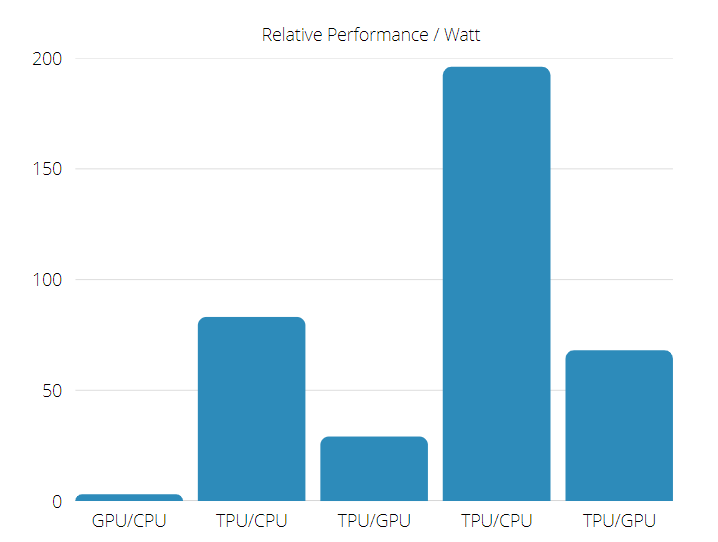

TPU jest od 15 do 30 razy szybszy niż obecne procesory graficzne i procesory w komercyjnych aplikacjach AI, które wykorzystują wnioskowanie o sieci neuronowej.

Co więcej, TPU jest znacznie energooszczędne, przy 30 do 80-krotnym wzroście wartości TOPS/Wat.

Porada eksperta: Niektóre problemy z komputerem są trudne do rozwiązania, zwłaszcza jeśli chodzi o uszkodzone repozytoria lub brakujące pliki systemu Windows. Jeśli masz problemy z naprawieniem błędu, twój system może być częściowo uszkodzony. Zalecamy zainstalowanie Restoro, narzędzia, które przeskanuje twoją maszynę i zidentyfikuje przyczynę usterki.

Kliknij tutaj aby pobrać i rozpocząć naprawę.

Stąd w tworzeniu TPU vs. Porównanie szybkości GPU, szanse są przekrzywione w kierunku jednostki przetwarzania tensorowego.

TPU a Wydajność GPU

TPU to maszyna do przetwarzania tensorów stworzona w celu przyspieszenia obliczeń grafów Tensorflow.

Na jednej płycie każda jednostka TPU może zapewnić nawet 64 GB pamięci o wysokiej przepustowości i 180 teraflopów wydajności zmiennoprzecinkowej.

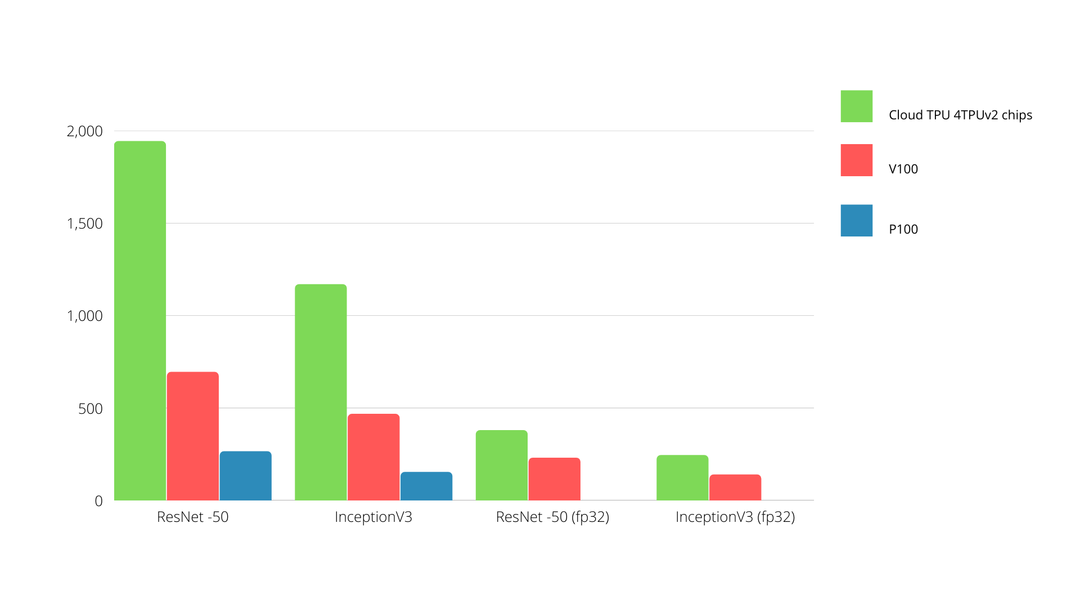

Poniżej przedstawiono porównanie między procesorami graficznymi Nvidia i TPU. Oś Y przedstawia liczbę zdjęć na sekundę, a oś X przedstawia różne modele.

TPU a Uczenie maszynowe GPU

Poniżej znajdują się czasy trenowania procesorów i procesorów graficznych przy użyciu różnych rozmiarów partii i iteracji w poszczególnych epokach:

- Liczba iteracji/epoka: 100, Wielkość partii: 1000, Całkowita liczba epok: 25, Parametry: 1,84 M i Typ modelu: Keras Mobilenet V1 (alfa 0,75).

| AKCELERATOR | GPU (NVIDIA K80) | TPU |

| Dokładność szkolenia (%) | 96.5 | 94.1 |

| Dokładność walidacji (%) | 65.1 | 68.6 |

| Czas na iterację (ms) | 69 | 173 |

| Czas na epokę (y) | 69 | 173 |

| Całkowity czas (minuty) | 30 | 72 |

- Liczba iteracji/epoka: 1000, wielkość partii: 100, całkowita liczba epok: 25, parametry: 1,84 mln i typ modelu: Keras Mobilenet V1 (alfa 0,75)

| AKCELERATOR | GPU (NVIDIA K80) | TPU |

| Dokładność szkolenia (%) | 97.4 | 96.9 |

| Dokładność walidacji (%) | 45.2 | 45.3 |

| Czas na iterację (ms) | 185 | 252 |

| Czas na epokę (y) | 18 | 25 |

| Całkowity czas (minuty) | 16 | 21 |

Przy mniejszym rozmiarze partii, trening TPU trwa znacznie dłużej, co widać po czasie treningu. Jednak wydajność TPU jest bliższa GPU ze zwiększonym rozmiarem partii.

Stąd w tworzeniu TPU vs. Porównanie treningu GPU ma wiele wspólnego z epokami i rozmiarem partii.

TPU a Test GPU

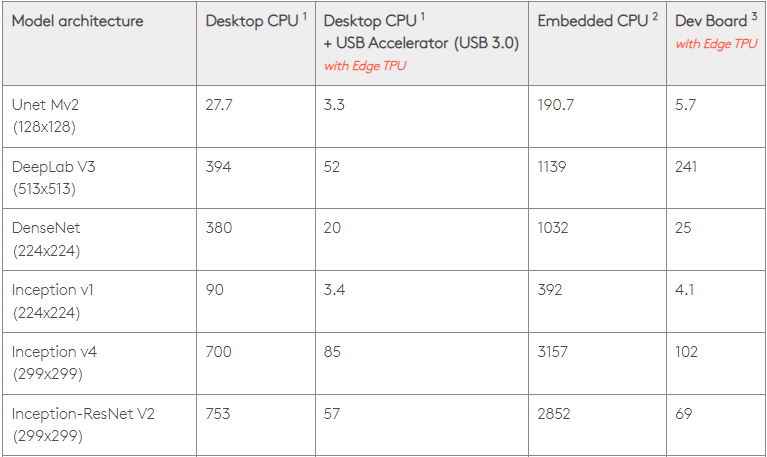

Przy mocy 0,5 W/TOPS pojedynczy Edge TPU może wykonać cztery biliony operacji na sekundę. Kilka zmiennych wpływa na to, jak dobrze przekłada się to na wydajność aplikacji.

Modele sieci neuronowych mają różne wymagania, a ogólna wydajność różni się w zależności od szybkości hosta USB, procesora i innych zasobów systemowych akceleratora USB.

Mając to na uwadze, poniższa grafika zestawia czas spędzony na wyciąganiu pojedynczych wniosków na Edge TPU z różnymi standardowymi modelami. Oczywiście, dla porównania, wszystkie działające modele to wersje TensorFlow Lite.

Należy pamiętać, że podane powyżej dane pokazują czas potrzebny do uruchomienia modelu. Nie obejmuje jednak czasu potrzebnego na przetworzenie danych wejściowych, który różni się w zależności od aplikacji i systemu.

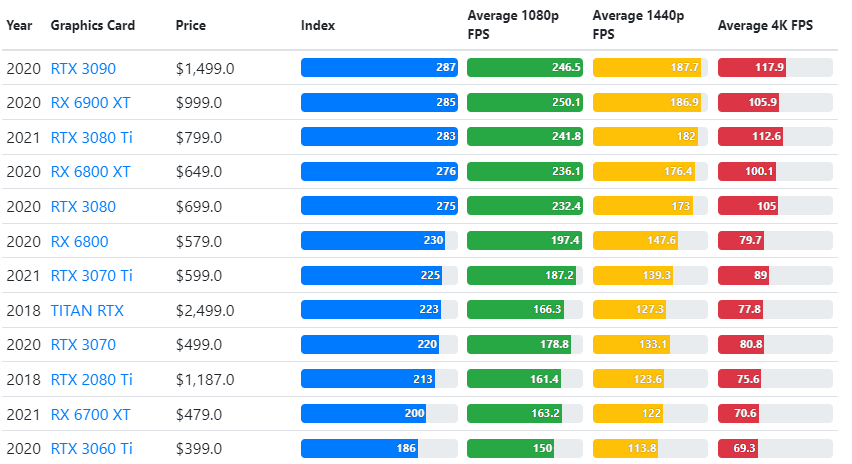

Wyniki testów GPU są porównywane z żądanymi przez użytkownika ustawieniami jakości rozgrywki i rozdzielczością.

W oparciu o ocenę ponad 70 000 testów porównawczych, skrupulatnie skonstruowano zaawansowane algorytmy, aby generować 90% wiarygodnych szacunków wydajności w grach.

Chociaż wydajność kart graficznych różni się znacznie w różnych grach, poniższy obraz porównawczy przedstawia szeroki indeks oceny niektórych kart graficznych.

- Bluetooth jest wyszarzony w Menedżerze urządzeń: 3 wskazówki, jak to naprawić

- 30 wskazówek, jak otworzyć i uruchomić nowy menedżer zadań systemu Windows 11

- 15 najlepszych usług przesyłania strumieniowego z reklamami [Najwyższa ocena]

- 5 kroków, aby naprawić nie znaleziono pliku qt5widgets.dll

TPU a Cena GPU

Mają znaczną różnicę w cenie. TPU są pięć razy droższe niż GPU. Oto kilka przykładów:

- Procesor graficzny Nvidia Tesla P100 kosztuje 1,46 USD za godzinę

- Google TPU v3 kosztuje 8,00 USD za godzinę

- TPUv2 z dostępem na żądanie GCP 4,50 USD za godzinę

Jeśli celem jest optymalizacja pod kątem kosztów, powinieneś wybrać TPU tylko wtedy, gdy trenuje model 5 razy szybciej niż GPU.

Jaka jest różnica między procesorem a GPU vs. TPU?

Różnica między TPU, GPU i procesorem polega na tym, że procesor jest procesorem niespecyficznym, który obsługuje wszystkie obliczenia, logikę, dane wejściowe i wyjściowe komputera.

Z drugiej strony GPU to dodatkowy procesor używany do ulepszania interfejsu graficznego (GI) i wykonywania zaawansowanych czynności. TPU to mocne, specjalnie wykonane procesory służące do realizacji projektów opracowanych przy użyciu konkretnego frameworka, takiego jak TensorFlow.

Kategoryzujemy je w następujący sposób:

- Jednostka centralna (CPU) - Kontroluj wszystkie aspekty komputera

- Jednostka przetwarzania grafiki (GPU) — poprawia wydajność grafiki komputera

- Tensor Processing Unit (TPU) – ASIC specjalnie zaprojektowany dla projektów TensorFlow

Czy Nvidia produkuje TPU?

Wiele osób zastanawiało się, jak NVIDIA zareaguje na TPU Google, ale teraz mamy odpowiedzi.

Zamiast się martwić, NVIDIA z powodzeniem zdepozycjonowała TPU jako narzędzie, z którego może korzystać, gdy ma to sens, ale nadal utrzymuje swoje oprogramowanie CUDA i procesory graficzne na czele.

Utrzymuje punkt kontrolny w zakresie wdrażania uczenia maszynowego IoT, udostępniając technologię open source. Jednak niebezpieczeństwo związane z tą metodą polega na tym, że może ona uwiarygodnić koncepcję, która może stać się wyzwaniem dla długoterminowych aspiracji silników wnioskowania centrów danych dla firmy NVIDIA.

Czy GPU czy TPU są lepsze?

Podsumowując, musimy powiedzieć, że chociaż opracowujemy algorytmy umożliwiające efektywne wykorzystanie TPU kosztuje nieco więcej, niższe koszty szkolenia generalnie przeważają nad dodatkowym programowaniem wydatki.

Inne powody, dla których warto wybrać TPU, to fakt, że G pamięci VRAM v3-128 8 przewyższa tę z GPU Nvidia, dzięki czemu v3-8 jest lepszą alternatywą do przetwarzania dużych zestawów danych związanych z NLU i NLP.

Wyższe prędkości mogą również prowadzić do szybszej iteracji podczas cykli tworzenia, prowadząc do szybszych i częstszych innowacji, zwiększając prawdopodobieństwo sukcesu na rynku.

TPU przewyższa GPU pod względem szybkości innowacji, łatwości użytkowania i przystępności; konsumenci i architekci chmury powinni wziąć pod uwagę TPU w swoich inicjatywach związanych z ML i AI.

TPU od Google ma duże możliwości przetwarzania, a użytkownik musi koordynować wprowadzanie danych, aby upewnić się, że nie ma przeciążenia.

Masz to, w sumie TPU vs. Porównanie GPU. Chętnie poznamy Twoje przemyślenia i sprawdzimy, czy wykonałeś jakieś testy i jakie wyniki uzyskałeś na TPU i GPU.

Pamiętaj, że możesz cieszyć się wciągającymi wrażeniami na komputerze, korzystając z dowolnego z najlepsze karty graficzne dla Windows 11.

Nadal masz problemy?Napraw je za pomocą tego narzędzia:

Nadal masz problemy?Napraw je za pomocą tego narzędzia:

- Pobierz to narzędzie do naprawy komputera ocenione jako świetne na TrustPilot.com (pobieranie rozpoczyna się na tej stronie).

- Kliknij Rozpocznij skanowanie aby znaleźć problemy z systemem Windows, które mogą powodować problemy z komputerem.

- Kliknij Naprawić wszystko rozwiązać problemy z opatentowanymi technologiami (Ekskluzywny rabat dla naszych czytelników).

Restoro zostało pobrane przez 0 czytelników w tym miesiącu.