- Verbesserter Funktionsaufruf

- JSON-Modus

- Reproduzierbare Ausgabe

- Vorschau

- 3x kostengünstiger

Während der Cloud-Entwicklerkonferenz von Microsoft erwähnte der CEO des Unternehmens, Satya Nadella, dass die Einführung aktualisierter generativer KI-Modelle bevorsteht Azure Open Services kommen bald.

Ab dieser Woche können Azure OpenAI Service-Kunden nun die fortschrittlichsten Versionen der vorgenerativen Modelle von OpenAI mit GTP-4 und GPT-3.5 Turbo 1106 nutzen.

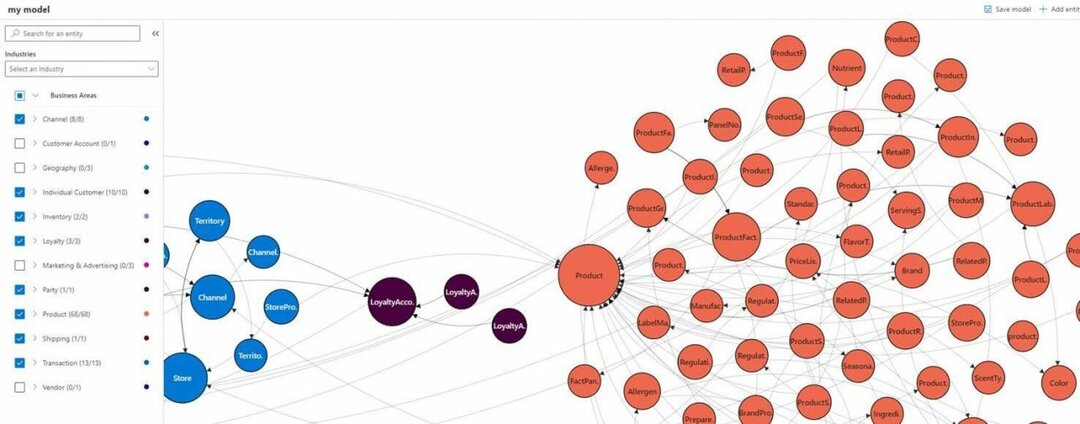

Microsoft führte die neuen Modelle in bereits bestehenden Märkten ein und öffnete seine Kanäle gleichzeitig für drei neue Regionen, darunter Norwegen im Osten, Südindien und den Westen der USA. Azure OpenAI Services sind mittlerweile in insgesamt vierzehn globalen Regionen verfügbar.

Die neuen Modelle, insbesondere der GTP4 Turbo, bringen Kenntnisse über das Weltgeschehen bis April 2023 sowie 128L mit Kontextfenster, die es Entwicklern ermöglichen, benutzerdefinierte Dateneingaben zu erstellen, die nun Retrieval Augmented Generation nutzen können (LAPPEN).

Was die Token-Preise für die neuen Modelle betrifft, so beträgt der GTP-4 Turbo-Preis 0,01 $/1000 Token für die Eingabe und 0,03 $/1000 Token für die Ausgabe. Basierend auf den Eingabe- und Ausgabemodellen ist GPT-4 Turbo für Azure OpenAI Services „3x kostengünstiger für.“ Eingabe-Tokens und 2x kostengünstiger für Ausgabe-Tokens“ im Vergleich zu den regulären GPT-4-Modellen, die verwendet werden Jetzt.

Über die Preisverbesserungen hinaus gibt es auch verbesserte Funktionen wie den Funktionsaufruf mit GPT-4 Turbo, der mehrere Funktions- und Toolaufrufe parallel ermöglicht, um Anwendungen effizienter zu machen. GPT-4 führt außerdem den JSON-Modus für die korrekte Formatierung der JSON-Ausgabe ein. Eine reproduzierbare Ausgabe wird ebenfalls ermöglicht und bringt wahrscheinliche Ergebnisse.

GPT-3.5 Turbo 1106 bietet viele der gleichen aktualisierten Funktionen wie GPT-4 Turbo, wird aber auch zum Standard-Turbo-Modell mit 16K-Kontextfenster und neuen Token-Eingabe-/Ausgabepreisen.

Wie bereits erwähnt, sind beide neuen GPT-Modelle für die meisten Kunden in der Vorschau verfügbar, wobei Microsoft verspricht, sie mit Provisioned Throughput breiter zugänglich zu machen.