Наступний крок у технології ШІ вже тут.

- Llama 2 дозволить вам створювати власні складні моделі ШІ.

- Ви зможете точно налаштувати та розгорнути моделі Llama 2 із параметрами 7B, 13B та 70B.

- І якщо ви розробник, який використовує Windows, вас чекає задоволення.

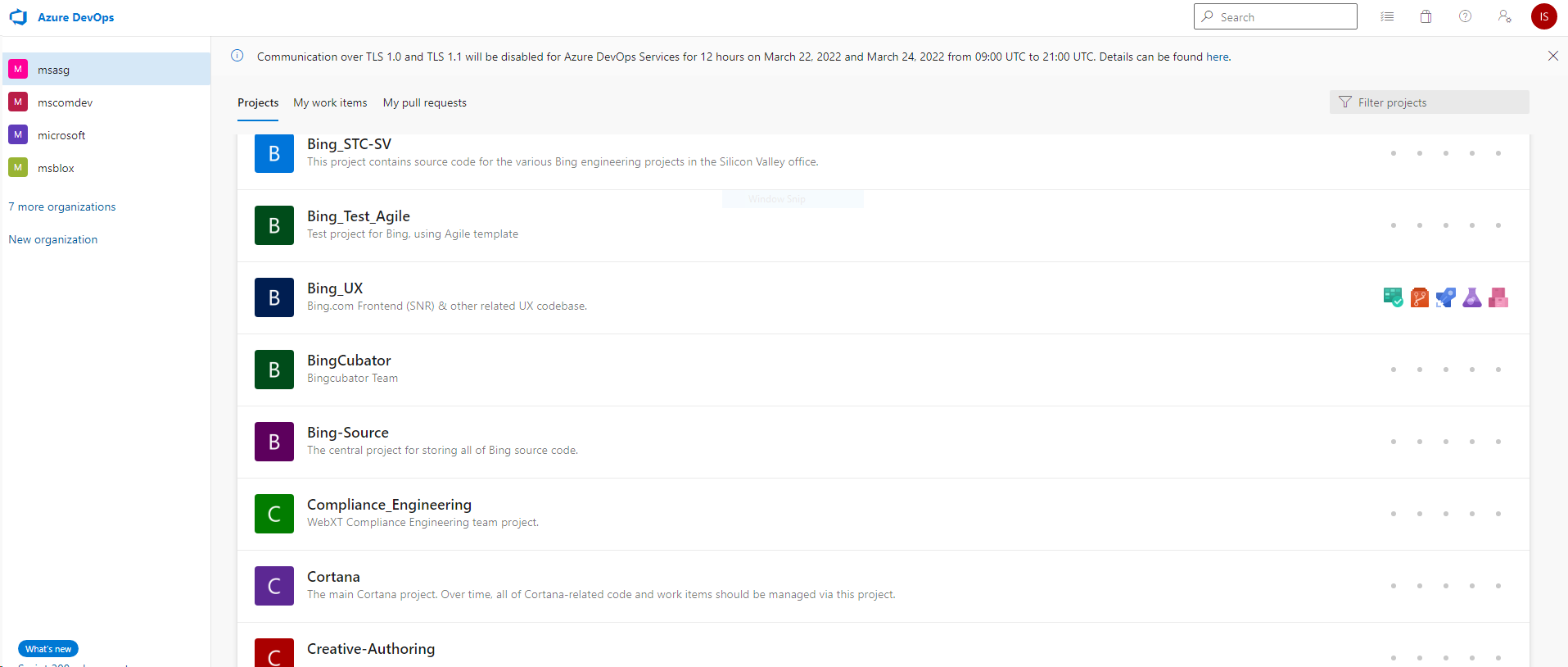

Біля Microsoft Inspire 2023 На конференції сталося щось захоплююче. Microsoft об'єднала зусилля з Meta створити партнерство AI з Llama 2.

Сьогодні на Microsoft Inspire Meta та Microsoft оголосили про підтримку сімейства великих мовних моделей (LLM) Llama 2 в Azure та Windows. Llama 2 розроблено, щоб дозволити розробникам і організаціям створювати генеративні інструменти та досвід на основі ШІ. Meta та Microsoft поділяють зобов’язання щодо демократизації ШІ та його переваг, і ми раді, що Meta використовує відкритий підхід до Llama 2. Ми пропонуємо розробникам вибір типів моделей, на яких вони будуються, підтримуючи відкриті та прикордонні моделі, і ми в захваті бути кращим партнером Meta, оскільки вони вперше випускають свою нову версію Llama 2 для комерційних клієнтів час.

Microsoft

Це має сенс, оскільки перший день конференції був присвячений ШІ. Microsoft анонсувала багато речей, пов’язаних зі ШІ окрім свого партнерства Meta AI. Сервіс Azure OpenAI тепер доступний в Азії після того, як нещодавно був випущений у Північній Америці та Європі.

Bing Chat Enterprise також було оголошено, і це версія Bing AI, але для роботи. Інструмент зараз доступний у попередньому перегляді. і, Партнерська програма Microsoft Cloud отримує оновлення ШІ. Тепер ви можете використовувати штучний інтелект для розробки бізнес-плану чи маркетингової стратегії, одночасно використовуючи його для створення портфоліо.

Тому, коли справа доходить до штучного інтелекту, Microsoft була в авангарді з самого початку. І тепер партнерство технічного гіганта з Редмонда з Meta може стати наступною великою подією у світі ШІ.

Як згадувалося раніше, Llama 2 дає змогу розробникам і організаціям створювати генеративні інструменти ШІ та досвід.

Ви зможете легко та безпечніше налаштовувати та розгортати моделі Llama 2 із параметрами 7B, 13B та 70B на Azure.

Крім того, вам потрібно знати, що Llama буде оптимізовано для локальної роботи в Windows. А якщо ви розробник, який працює в Windows, ви зможете використовувати Llama, націлившись на постачальника виконання DirectML через середовище виконання ONNX.

Розробники Windows також зможуть легко створювати нові можливості за допомогою Llama 2, до якої можна отримати доступ через GitHub Repo. Завдяки підсистемі Windows для Linux і високопродуктивним графічним процесорам ви можете точно налаштувати LLM відповідно до ваших конкретних потреб прямо на їхніх ПК з Windows.

Що ви думаєте про це партнерство? Повідомте нам у розділі коментарів нижче.