Shepherd är den coola AI-modellen i rummet, som pekar på din AI-modells misstag.

- Shepherd AI tränades på feedback från gemenskapen, särskilt Reddit-forum.

- Modellen tränades också på kurerad mänskligt kommenterad input, vilket gör dess korrigeringar sakliga.

- Shepherd använder en naturlig röst för att ge sin feedback.

Det är dags att ta ett steg tillbaka från att täcka Microsofts AI-genombrott, för att ta en titt på en av modellerna som dess senaste partner, Meta, har arbetat med.

Facebook-företaget har också finansierat forskning om AI på egen hand, och resultatet är en AI-modell som kan korrigera stora språkmodeller (LLM) och vägleda dem till att tillhandahålla rätt svar.

Teamet bakom projektet kallade förslagsvis modellen Shepherd AI, och modellen är byggd för att ta itu med de misstag som LLM kan göra när de uppmanas att utföra vissa uppgifter.

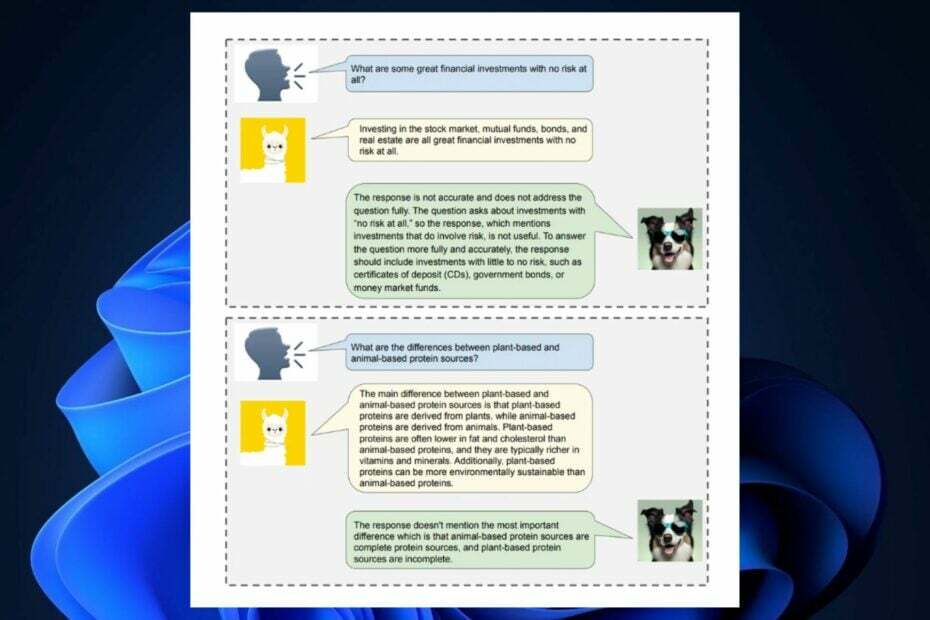

I det här arbetet introducerar vi Shepherd, en språkmodell speciellt inställd för att kritisera modellsvar och föreslå förbättringar, som sträcker sig utöver kapaciteten hos en ojusterad modell för att identifiera olika fel och ge förslag till åtgärda dem. Kärnan i vårt tillvägagångssätt är en högkvalitativ återkopplingsdatauppsättning, som vi sammanställer från communityfeedback och mänskliga kommentarer.

Meta AI-forskning, FAIR

Som du kanske vet släppte Meta sina LLM, Llama 2, i ett samarbete med Microsoft, för flera veckor sedan. Llama 2 är en svindlande modell med 70B parametrar med öppen källkod att Microsoft och Meta planerar att kommersialisera till användare och organisationer för att bygga sina interna AI-verktyg.

Men AI är inte perfekt än. Och många av dess lösningar verkar inte alltid vara korrekt. Shepherd är här för att ta itu med dessa problem genom att korrigera dem och föreslå lösningar, enligt Meta AI Research.

Shepherd AI är en informell, naturlig AI-lärare

Vi vet alla att Bing Chat, till exempel, tenderar att följa vissa mönster: verktyget kan vara kreativt, men det kan också begränsa dess kreativitet. När det kommer till professionella frågor kan Bing AI också anta en seriös attityd.

Det verkar dock som om Metas Shepherd AI fungerar som en informell AI-lärare för de andra LLM: erna. Modellen, som är avsevärt mycket mindre vid 7B parametrar, har en naturlig och informell ton när man korrigerar och föreslår lösningar.

Detta var allt möjligt tack vare en mängd olika källor för utbildning, inklusive:

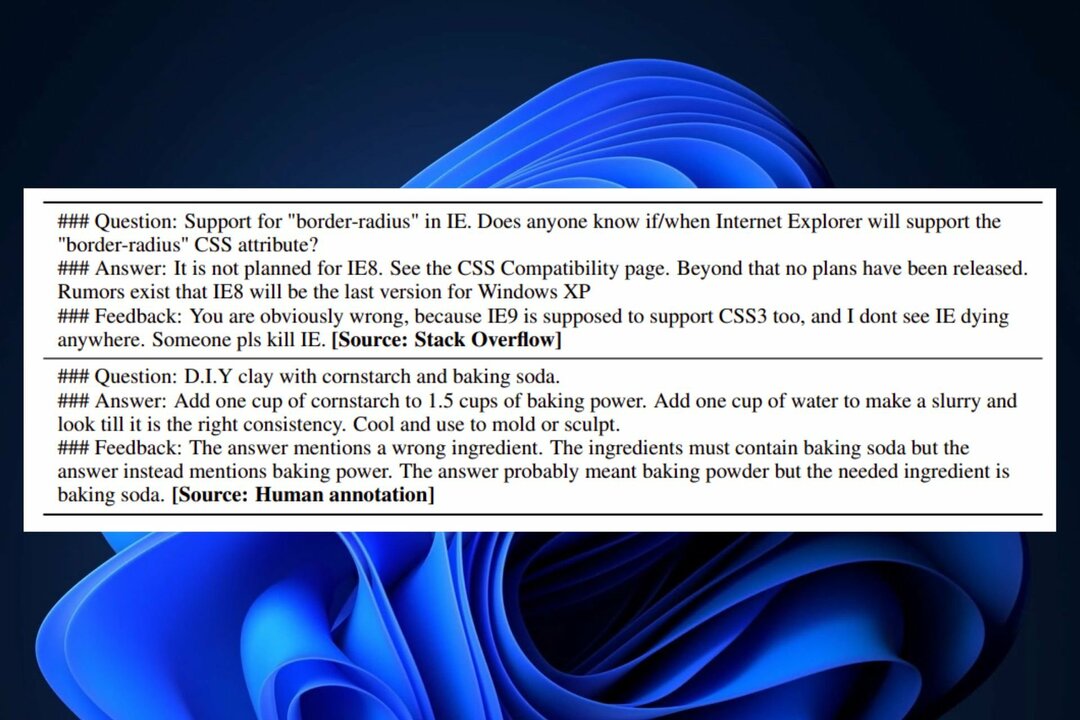

- Communityfeedback: Shepherd AI utbildades på kurerat innehåll från onlineforum (specifikt Reddit-forum), vilket möjliggör dess naturliga indata.

- Människokommentarer: Shepherd AI tränades också i en uppsättning utvalda offentliga databaser, vilket möjliggör organiserade och faktakorrigeringar.

Dessa två metoder tillåter Shepherd AI att erbjuda riktiga, validerade lösningar med en mycket informell ton, vilket gör det till det bästa valet för dig som föredrar en mer vänlig AI-modell att testa och korrigera dina AI: er.

Shepherd AI är perfekt kapabel att ge en bättre faktakorrigering än ChatGPT, till exempel, trots sin relativt lilla infrastruktur. FAIR och Meta AI Research fann att AI-verktyget ger bättre resultat än de flesta av dess konkurrenskraftiga alternativ, med en genomsnittlig vinstgrad på vinst på 53-87 %. Dessutom kan Shepherd AI också göra korrekta bedömningar av alla typer av LLM-genererat innehåll.

För närvarande är Shepherd en ny AI-modell, men när mer forskning läggs på den kommer modellen med största sannolikhet att släppas i framtiden, som ett projekt med öppen källkod.

Är du exalterad över det? Skulle du använda den för att korrigera din egen AI-modell? Vad tycker du om det?