- Den nya superdator som utvecklats tillsammans med OpenAI är ett enda system med mer än 285 000 CPU-kärnor, 10 000 GPU: er och 400 gigabit per sekund nätverksanslutning för varje GPU-server.

- Microsoft skriver att comparad med andra maskiner som listas på TOP500 superdatorer i världen rankas deras system bland de fem bästa.

- Årets Build-evenemang var fullt av överraskningar. Kolla in nyheterna från vår Microsoft Build 2020-avsnitt.

- De Microsoft News Hub är där du alltid hittar de viktigaste berättelserna om företaget.

Partnerskapet som Microsoft tillkännagav förra året med den artificiella intelligensen StartAI har varit fruktbart, för att säga åtminstone för att de meddelade att de har byggt den femte mest kraftfulla AI-datorn i världen vid årets Build-evenemang.

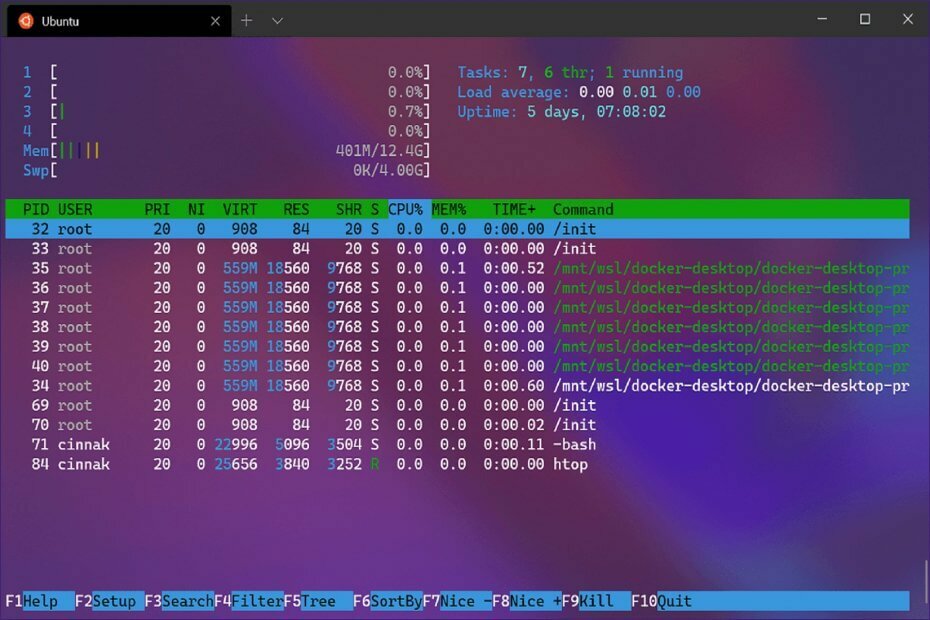

Vad är tekniska specifikationer för Microsoft AI superdator?

Den superdator som utvecklats tillsammans med OpenAI är ett enda system med mer än 285 000 CPU-kärnor, 10 000 GPU: er och 400 gigabit per sekund nätverksanslutning för varje GPU-server.

Microsoft skriver i ett blogginlägg att comparad med andra maskiner som listas på TOP500 superdatorer i världen, deras system rankas bland de fem bästa.

Det handlar om att kunna göra hundra spännande saker i naturlig språkbehandling samtidigt och hundra spännande saker i datorsyn, och när du börjar se kombinationer av dessa perceptuella domäner kommer du att ha nya applikationer som det är svårt att ens föreställa sig just nu.

, sa OpenAI-VD Sam Altman.

Vad ska Microsoft AI superdator användas för?

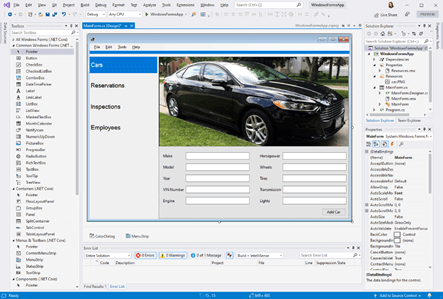

Microsoft meddelade att det snart skulle börja erbjuda sina Microsoft Turing-modeller i öppen källkod och recept för att träna dem i Azure Machine Learning.

Om du är utvecklare får du tillgång till samma familj av språkmodeller som Microsoft använder för att förbättra språkförståelsen i alla sina produkter.

De kommer också att använda superdatorn med den nya versionen av DeepSpeed.

För de som inte är bekanta med det är DeepSpeed ett open-source deep-learning-bibliotek för PyTorch, vilket minskar mängden datorkraft som behövs för stor distribuerad modellutbildning.

Uppdateringen är mycket bättre än den version som släpptes för tre månader sedan. Nu tillåter det träningsmodeller mer än 15 gånger större och 10 gånger snabbare än att göra samma sak utan DeepSpeed på samma infrastruktur.