Gry staną się o wiele bardziej realne

- Gry w systemie Windows staną się coraz bardziej zabawne i interaktywne.

- NVIDIA zaprezentowała ACE podczas niedawnego przemówienia, podczas którego dokonano ujawnień.

- Korzystając z tej nowej technologii, NPC mogą rozmawiać z postaciami graczy w czasie rzeczywistym.

Być może już to wiesz, ale podczas wczorajszego przemówienia na targach Computex na Tajwanie dyrektor generalny firmy NVIDIA, Jensen Huang, zaprezentował nową technologię dla twórców gier.

I tak, ta nowa technologia obejmuje wykorzystanie sztucznej inteligencji i serwerów w chmurze, co stało się nowym, dużym celem firmy.

Nie psując jeszcze niczego, po prostu wiedz, że ta nowa technologia faktycznie wykorzysta Microsoft Czat GPT i Google BARD oprogramowanie sztucznej inteligencji.

Interakcje NPC staną się coraz bardziej realne

Ta nowa technologia nazywa się NVIDIA ACE (silnik chmury awatara) dla gier. To nie jest najkrótsza nazwa, ale możesz po prostu użyć akronimu.

Prawdę mówiąc, pozwoli to programistom umieścić NPC, którzy mogą rozmawiać z postaciami graczy w czasie rzeczywistym, ale z dialogiem, który nie jest oparty na skrypcie i jest obsługiwany przez chatboty AI podobne do ChatGPT, Bing Chat i Bard.

Co więcej, będziesz mógł również dopasować animacje twarzy NPC do nieskryptowanych dialogów. Jak to jest w przypadku technologii z 2023 roku?

Dzięki niemu możesz ożywić NPC za pomocą technik dopasowania modelu NeMo. Po pierwsze, zastosuj klonowanie zachowań, aby umożliwić modelowi języka podstawowego wykonywanie zadań odgrywania ról zgodnie z instrukcjami.

Aby jeszcze bardziej dostosować zachowanie NPC do oczekiwań, w przyszłości możesz zastosować wzmocnienie uczenie się na podstawie informacji zwrotnych od ludzi (RLHF) w celu otrzymywania informacji zwrotnych od projektantów w czasie rzeczywistym podczas opracowywania proces.

Firma stwierdziła również, że ci NPC AI są kontrolowani przez NeMo Guardrails, co, miejmy nadzieję, powstrzyma ich od mówienia graczom dziwnych, a nawet obraźliwych rzeczy.

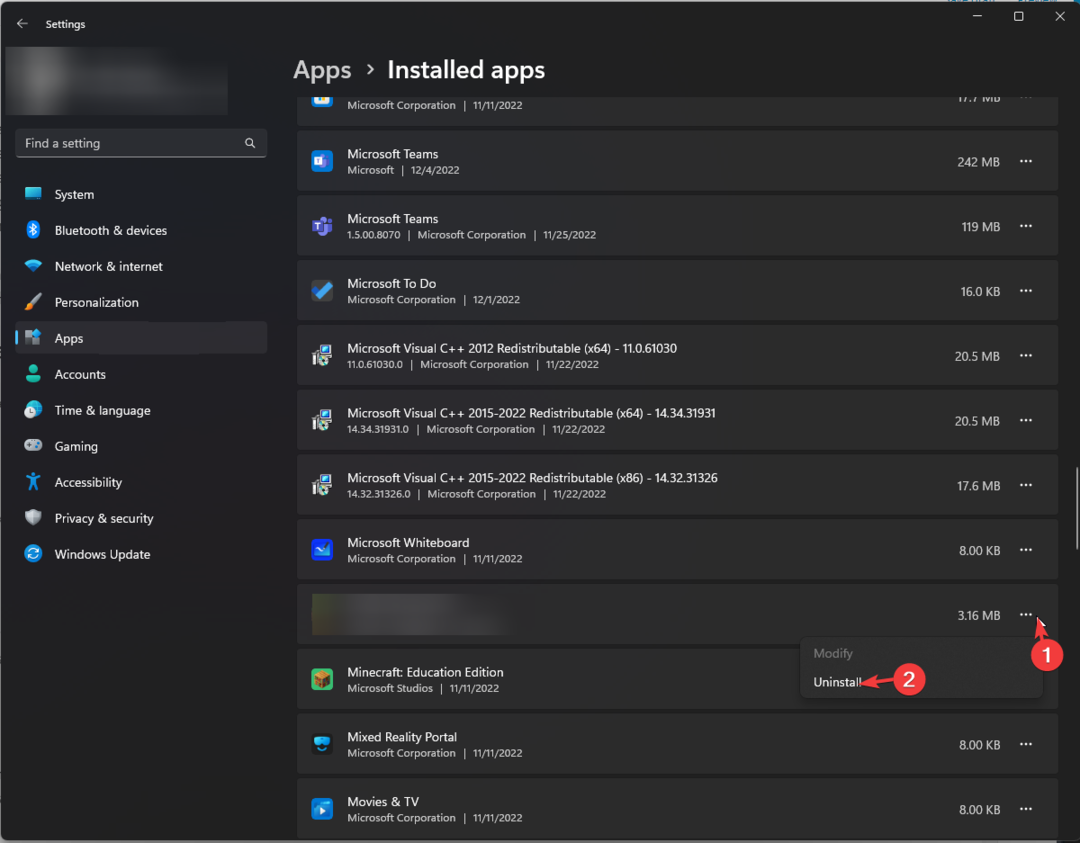

Jak widać powyżej, NVIDIA zaprezentowała krótką wersję demonstracyjną ACE, która została opublikowana na YouTube. Powstała w silniku Unreal Engine 5 z włączonym ray tracingiem i technologią MetaHuman dla modeli postaci NPC.

NVIDIA wykorzystała również technologię start-upu Convai, który tworzy postacie AI w grach.

Pamiętaj, że Convai używał NVIDIA Riva do funkcji zamiany mowy na tekst i zamiany tekstu na mowę, NVIDIA NeMo dla LLM, który kieruje rozmową, oraz Audio2Face dla animacji twarzy opartej na sztucznej inteligencji z głosu wejścia.

AI NPC pokazany w demie zdecydowanie nie jest doskonały. Jego sposób mówienia wydawał się bardzo sztywny i, ośmielamy się powiedzieć, sztuczny z natury.

To powiedziawszy, jest więcej niż prawdopodobne, że wzorce mowy ulegną poprawie i staną się bardziej naturalne w nadchodzących miesiącach i latach.

Jednak NVIDIA nie podała, kiedy ACE for Games będzie dostępne dla twórców gier, więc nie wyprzedzajmy się zbytnio.

Technologia Audio2Face, która dopasowuje animację twarzy do mowy postaci w grze, zostanie wykorzystana w dwóch nadchodzących grach: trzecioosobowej grze science-fiction Fort Solisoraz długo oczekiwana kontynuacja postapokaliptycznej gry FPS PRZEŚLADOWCA. 2: Serce Czarnobyla.

Co sądzisz o ostatnich wiadomościach od firmy NVIDIA? Podziel się z nami swoimi opiniami w sekcji komentarzy poniżej.