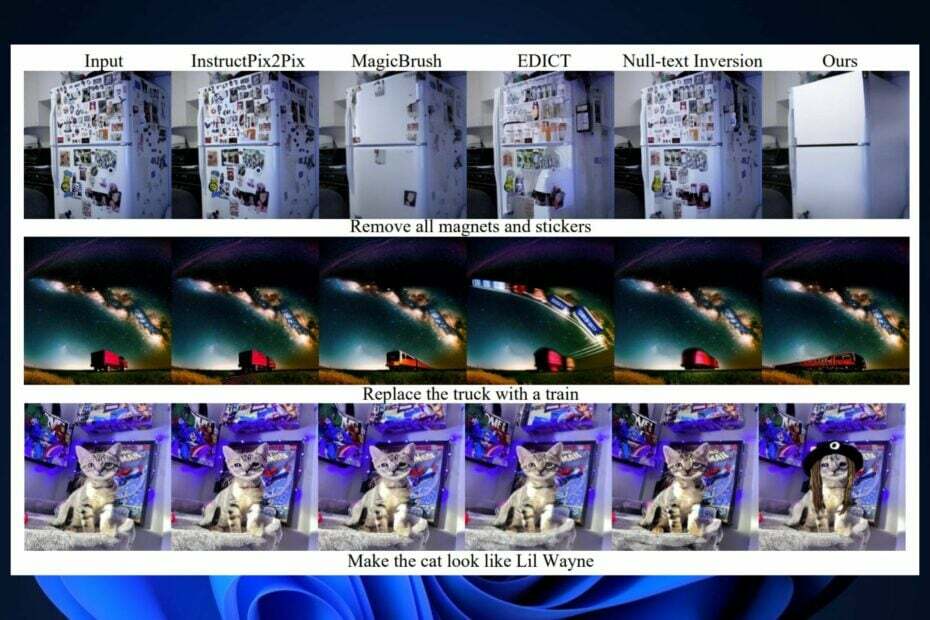

InstructDiffusion er i stand til å forstå semantiske betydninger og vil bruke dem til å redigere bildene dine.

- InstructDiffusion er en AI som er i stand til å bruke tidligere instruksjoner for å få muligheten til å forstå semantiske betydninger.

- Modellen er også i stand til imponerende generaliseringsevner.

- Når den først har lært om en visuell pekepinn, vil modellen utvide den kraftig for å trene seg selv ytterligere.

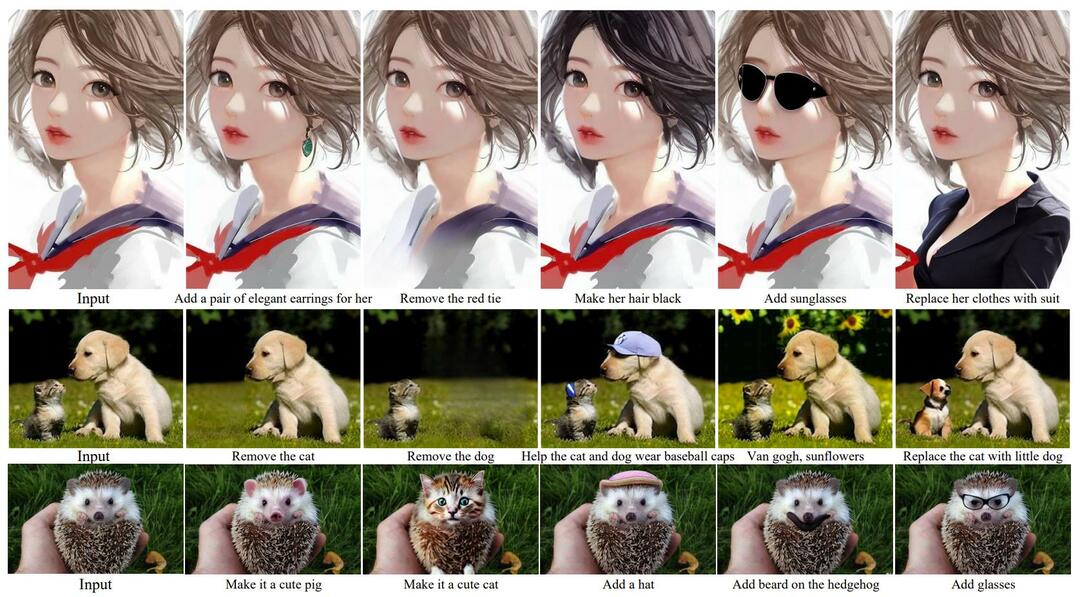

Microsofts nyeste AI-modell, Instruer diffusjon, vil radikalt transformere bildene dine, eller et hvilket som helst bilde du kan laste opp, i henhold til instruksjonene dine. Modellen, utviklet av Microsoft Research Asia, er et grensesnitt som samler AI og menneskelige instruksjoner for å generere og fullføre en rekke visuelle oppgaver.

Med andre ord, du velger et bilde som du vil redigere, endre eller transformere, og InstructDiffusion vil få datasynet til å endre bildet basert på input.

Microsoft utgitt avisen for modellen for noen dager siden, og InstructDiffusion har allerede en demo lekeplass, hvor du kan prøve modellen selv.

Nøkkelinnovasjonen i IntructDiffusion er at modellen ikke trenger forkunnskaper om bildet, men i stedet bruker den en diffusjonsprosess for å manipulere piksler. Modellen er i stand til mange nyttige funksjoner som segmentering, nøkkelpunktdeteksjon og restaurering. Praktisk talt vil InstructDiffusion bruke instruksjonene dine for å endre bildet.

I ett eksempel var Microsoft Research Asia i stand til å fjerne vannmerket på et bilde ved ganske enkelt å instruere modellen om å gjøre det.

Microsofts InstructDiffusion er i stand til å skille betydningen bak instruksjonene dine

InstructDiffusion, som mange andre Microsoft AI-modeller, er i stand til innovativ oppførsel når det gjelder å løse oppgaver. Microsoft Research Asia hevder at InstructDiffusion implementerer forståelsesoppgaver og generative oppgaver.

Modellen vil bruke forståelsesoppgaver, som segmentering og nøkkelpunktdeteksjon for å finne området og piksler som du vil at den skal redigere.

For eksempel bruker modellen segmentering for å lykkes med å finne området for følgende instruksjon: mal mannen til høyre for bildet rød. For nøkkelpunktdeteksjon vil en instruksjon være: bruk gult for å omringe kneet til mannen helt til venstre i bildet.

De generative oppgavene består av redigerings- og gjenopprettingsoppgaver. Ikke bare InstructDiffusion vil redigere bildet ditt, men modellen vil også generere nye elementer for bildet, basert på instruksjonene dine.

Microsoft InstructDiffusions mest lovende funksjon er dens evne til å lykkes med å generalisere alle instruksjonene den mottar for å danne en sammenhengende og dyp forståelse av meningen bak dem. Modellen vil med andre ord huske instruksjonene du ga den, og den vil med hell bruke dem til å trene seg selv videre.

Men modellen vil også lære å skille betydninger bak instruksjonene dine, noe som fører til at den løser usynlige oppgaver og kommer opp med nye måter å generere elementer på. Denne evnen til å forstå semantiske betydninger plasserer InstructDifussion et skritt lenger enn de andre lignende modellene: den utkonkurrerer dem.

InstructDiffusion er imidlertid også et skritt videre for å nå AGI: Ved å forstå den semantiske betydningen bak hver instruksjon, og være i stand til å generalisere datasyn, vil modellen i stor grad fremme AI-utviklingen.

Microsoft Research Asia lar deg prøve det i en demo lekeplass, men du kan også bruk dens kode å trene din egen AI-modell.

Hva er dine meninger om denne modellen? Vil du prøve det?