Shepherd er den kule AI-modellen i rommet, og peker på feilene til AI-modellen din.

- Shepherd AI ble trent på tilbakemeldinger fra fellesskapet, spesielt Reddit-fora.

- Modellen ble også trent på kuratert menneskekommenterte input, noe som gjør rettelsene saklige.

- Shepherd bruker en naturlig stemme for å gi tilbakemelding.

Det er på tide å ta et skritt tilbake fra å dekke Microsofts AI-gjennombrudd, for å ta en titt på en av modellene deres nylige partner, Meta, har jobbet med.

Facebook-selskapet har også finansiert forskning på AI på egen hånd, og resultatet er en AI-modell som er i stand til å korrigere store språkmodeller (LLM) og veilede dem til å gi de riktige svar.

Teamet bak prosjektet kalte suggestivt modellen Shepherd AI, og modellen er bygget for å adressere feilene LLM-er kan gjøre når de blir bedt om å utføre visse oppgaver.

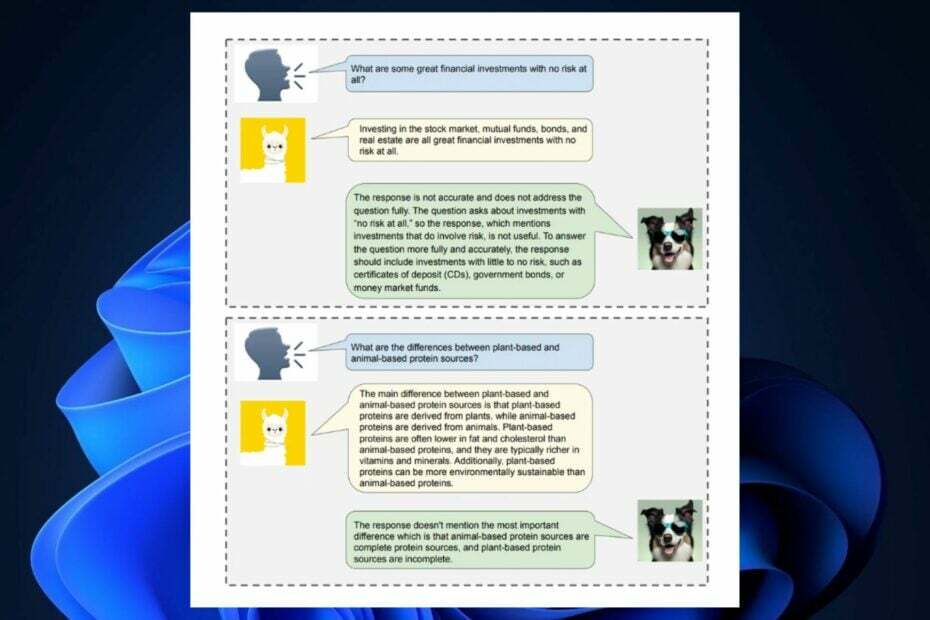

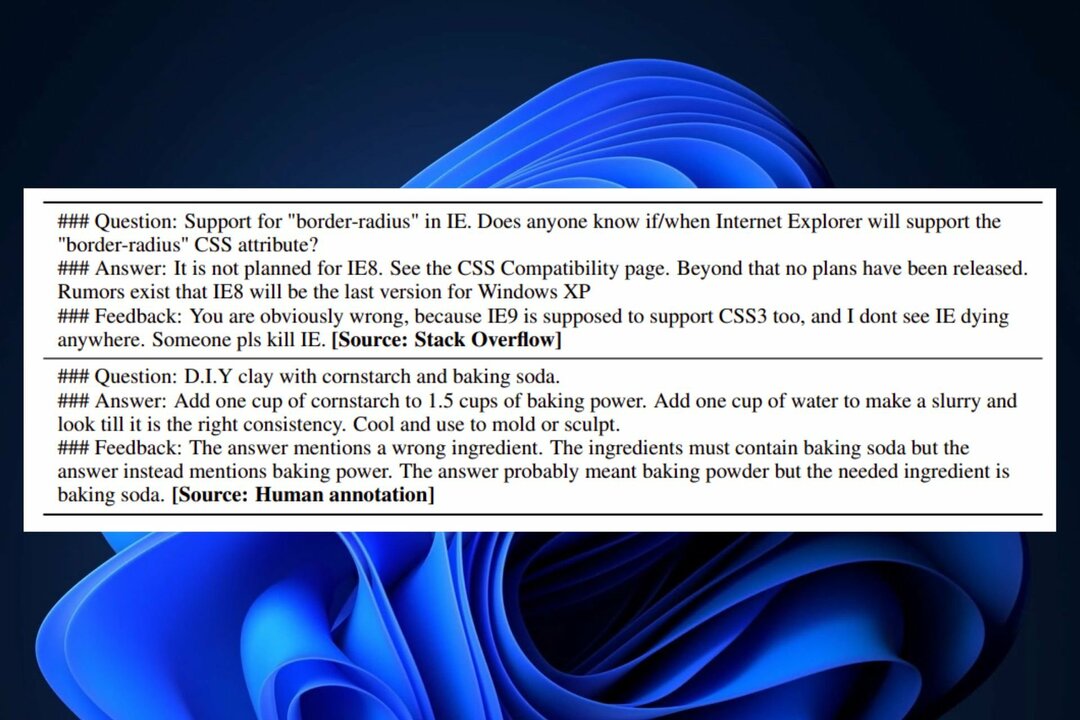

I dette arbeidet introduserer vi Shepherd, en språkmodell spesifikt innstilt for å kritisere modellsvar og foreslå forbedringer, som strekker seg utover mulighetene til en ujustert modell for å identifisere forskjellige feil og gi forslag til bøte på dem. Kjernen i vår tilnærming er et tilbakemeldingsdatasett av høy kvalitet, som vi kuraterer fra tilbakemeldinger fra samfunnet og menneskelige kommentarer.

Meta AI-forskning, FAIR

Som du kanskje vet, ga Meta ut sine LLM-er, Llama 2, i et samarbeid med Microsoft, for flere uker siden. Llama 2 er en svimlende 70B parametere åpen kildekode-modell at Microsoft og Meta planlegger å kommersialisere til brukere og organisasjoner for å bygge deres interne AI-verktøy.

Men AI er ikke perfekt ennå. Og mange av løsningene ser ikke alltid ut til å være riktig. Shepherd er her for å løse disse problemene ved å rette dem og foreslå løsninger, ifølge Meta AI Research.

Shepherd AI er en uformell, naturlig AI-lærer

Vi vet alle at Bing Chat, for eksempel, har en tendens til å følge noen mønstre: verktøyet kan være kreativt, men det kan også begrense kreativiteten. Når det kommer til faglige spørsmål, kan Bing AI også innta en seriøs holdning.

Imidlertid ser det ut til at Metas Shepherd AI fungerer som en uformell AI-lærer for de andre LLM-ene. Modellen, som er betydelig langt mindre ved 7B parametere, har en naturlig og uformell tone når du korrigerer og foreslår løsninger.

Dette var alt mulig takket være en rekke kilder for opplæring, inkludert:

- Tilbakemelding fra fellesskapet: Shepherd AI ble trent på kuratert innhold fra nettfora (spesifikt Reddit-fora), som muliggjør dets naturlige input.

- Menneskekommentarer: Shepherd AI ble også opplært på et sett med utvalgte offentlige databaser, som muliggjør organiserte og faktiske rettelser.

Disse to metodene lar Shepherd AI tilby ekte, validerte løsninger med en veldig uformell tone, gjør det til det beste valget for de av dere som foretrekker en mer vennlig AI-modell å teste og korrigere AI-ene dine.

Shepherd AI er perfekt i stand til å gi en bedre faktakorrigering enn ChatGPT, for eksempel, til tross for sin relativt lille infrastruktur. FAIR og Meta AI Research fant at AI-verktøyet gir bedre resultater enn de fleste konkurrerende alternativer, med en gjennomsnittlig gevinstrate på vinnerrate på 53–87 %. I tillegg kan Shepherd AI også gjøre nøyaktige vurderinger av alle slags LLM-generert innhold.

Foreløpig er Shepherd en ny AI-modell, men etter hvert som mer forskning blir satt inn i den, vil modellen mest sannsynlig bli utgitt i fremtiden, som et åpen kildekode-prosjekt.

Er du spent på det? Ville du brukt den til å korrigere din egen AI-modell? Hva synes du om det?