Neste steg i AI-teknologi er her.

- Llama 2 lar deg bygge dine egne komplekse AI-modeller.

- Du vil kunne finjustere og distribuere Llama 2-modellene med 7B, 13B og 70B parameter.

- Og hvis du er en utvikler som bruker Windows, har du en godbit.

På Microsoft Inspire 2023 Konferanse, noe spennende skjedde. Microsoft slo seg sammen med Meta å danne et AI-partnerskap med Llama 2.

I dag, hos Microsoft Inspire, kunngjorde Meta og Microsoft støtte for Llama 2-familien av store språkmodeller (LLM) på Azure og Windows. Llama 2 er designet for å gjøre det mulig for utviklere og organisasjoner å bygge generative AI-drevne verktøy og opplevelser. Meta og Microsoft deler en forpliktelse til å demokratisere AI og dens fordeler, og vi er glade for at Meta tar en åpen tilnærming med Llama 2. Vi tilbyr utviklere valg i hvilken type modeller de bygger på, støtter åpne og grensemodeller og er begeistret å være Metas foretrukne partner når de lanserer sin nye versjon av Llama 2 til kommersielle kunder for første gang tid.

Microsoft

Det er fornuftig, siden den første dagen av konferansen handlet om AI. Microsoft annonserte mange ting AI-relatert bortsett fra Meta AI-partnerskapet. Azure OpenAI Service er nå tilgjengelig i Asia etter nylig å ha blitt utgitt i Nord-Amerika og Europa.

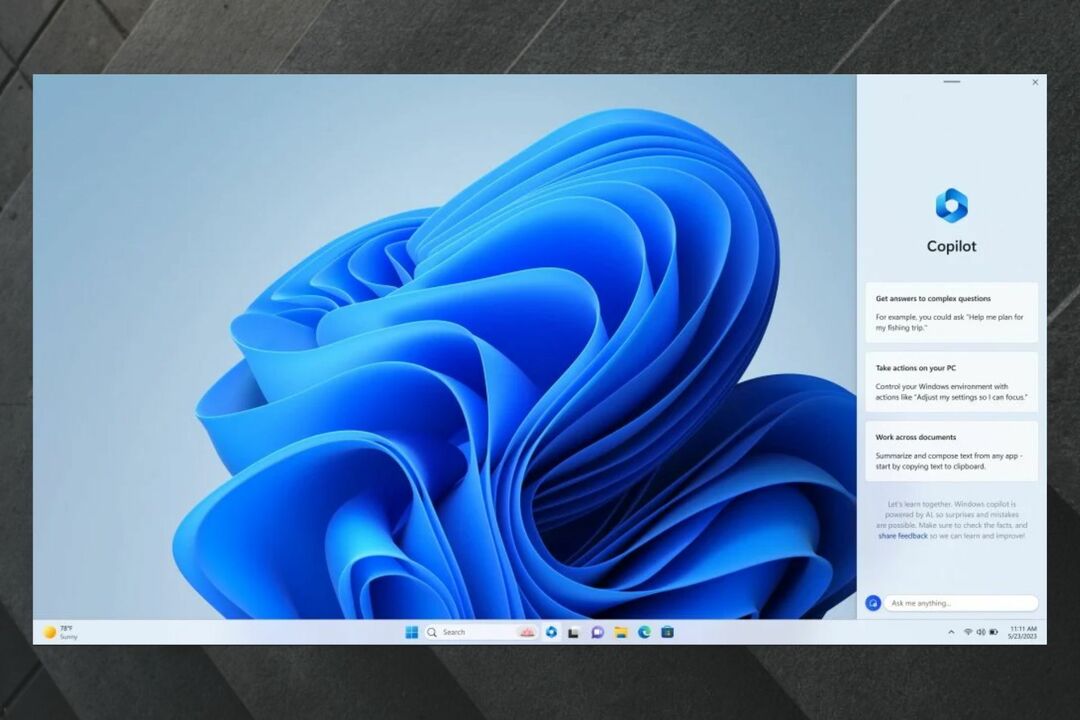

Bing Chat Enterprise ble også annonsert, og det er versjonen av Bing AI, men for jobb. Verktøyet er nå tilgjengelig i forhåndsvisning. Og, Microsoft Cloud Partner Program får en AI-oppdatering. Du kan nå bruke AI til å utvikle forretningsplanen eller markedsføringsstrategien din samtidig som du utnytter den til å bygge en portefølje.

Så når det kommer til AI, har Microsoft vært i forkant av det helt fra starten. Og nå kan det Redmond-baserte teknologigiganten-partnerskapet med Meta bli den neste store tingen i AI-verdenen.

Som det ble nevnt tidligere, gjør Llama 2 det mulig for utviklere og organisasjoner å bygge generative AI-verktøy og -opplevelser.

Du vil kunne finjustere og distribuere Llama 2-modellene med 7B, 13B og 70B-parametere enkelt og sikrere på Azure.

I tillegg må du vite at Llama vil bli optimalisert for å kjøre lokalt på Windows. Og hvis du er en utvikler som jobber på Windows, vil du kunne bruke Llama ved å målrette direkteML-utførelsesleverandøren gjennom ONNX Runtime.

Windows-utviklere vil også enkelt kunne bygge nye opplevelser ved å bruke Llama 2 som kan nås via GitHub Repo. Med Windows Subsystem for Linux og svært dyktige GPUer kan du finjustere LLM-er for å møte dine spesifikke behov rett på deres Windows-PCer.

Hva synes du om dette samarbeidet? Gi oss beskjed i kommentarfeltet nedenfor.