- Tensor Processing Units er spesialiserte integrerte kretser (IC) for spesifikke applikasjoner som er nyttige for å akselerere ML-arbeidsbelastninger.

- Mens NVIDIA fokuserer på GPU-er, har google vært banebrytende for TPU-teknologi og er ledende i denne avdelingen.

- TPU-er tillater en mye redusert treningskostnad som oppveier de første ekstra programmeringsutgiftene.

XINSTALLER VED Å KLIKKE LAST NED FILEN

Denne programvaren vil holde driverne i gang, og dermed holde deg trygg mot vanlige datamaskinfeil og maskinvarefeil. Sjekk alle driverne dine nå i tre enkle trinn:

- Last ned DriverFix (verifisert nedlastningsfil).

- Klikk Start søk for å finne alle problematiske drivere.

- Klikk Oppdater drivere for å få nye versjoner og unngå systemfeil.

- DriverFix er lastet ned av 0 lesere denne måneden.

I denne artikkelen skal vi lage en TPU vs. GPU sammenligning. Men før vi går inn i det, her er det du må vite.

Maskinlæring og AI-teknologi har akselerert veksten av intelligente apper. For dette formål skaper halvlederfirmaer kontinuerlig akseleratorer og prosessorer, inkludert TPU og CPU, for å håndtere mer komplekse apper.

Noen brukere har hatt problemer med å forstå når det anbefales å bruke en TPU og når de skal bruke en GPU for sine datamaskinoppgaver.

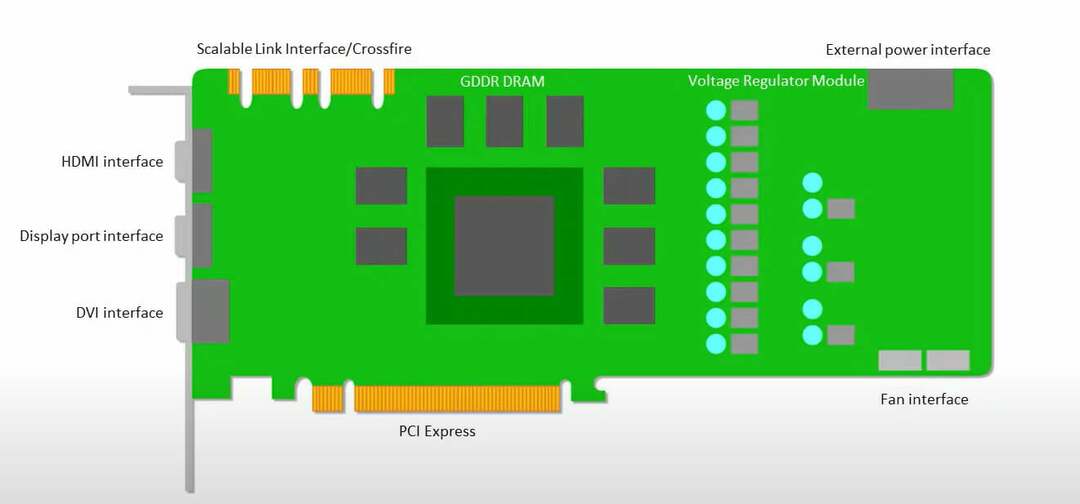

En GPU, også kjent som en grafisk prosesseringsenhet, er PC-ens skjermkort for å tilby deg en visuell og oppslukende PC-opplevelse. Du kan for eksempel følge enkle trinn hvis du PC-en oppdager ikke GPU.

For bedre å forstå disse omstendighetene, må vi også klargjøre hva en TPU er og hvordan den kan sammenlignes med en GPU.

Hva er en TPU?

TPUer eller Tensor Processing Units er spesialiserte integrerte kretser (ICs) for spesifikke applikasjoner, også kjent som ASICs (applikasjonsspesifikke integrerte kretser). Google skapte TPU-er fra bunnen av, begynte å bruke dem i 2015, og åpnet dem for publikum i 2018.

TPU-er tilbys som mindre brikke- eller skyversjoner. For å øke hastigheten på maskinlæring for et nevralt nettverk ved hjelp av TensorFlow-programvaren, løser sky-TPUer kompliserte matrise- og vektoroperasjoner med utrolige hastigheter.

Med TensorFlow utviklet Google Brain Team en maskinlæringsplattform med åpen kildekode, forskere, utviklere og bedrifter kan konstruere og betjene AI-modeller ved hjelp av Cloud TPU-maskinvare.

Når du trener komplekse og robuste nevrale nettverksmodeller, reduserer TPU-er tiden til nøyaktighetsverdi. Dette betyr at dyplæringsmodeller som kan ha tatt uker å trene med GPU-er, tar mindre enn en brøkdel av den tiden.

Er TPU det samme som GPU?

De er arkitektonisk svært forskjellige. En grafisk prosesseringsenhet er en prosessor i seg selv, om enn en som er ledet mot vektorisert numerisk programmering. GPUer er faktisk neste generasjon av Cray-superdatamaskiner.

TPU-er er koprosessorer som ikke utfører instruksjoner selv; koden kjøres på CPUer, som mater TPU-en med en flyt av små operasjoner.

Når bør jeg bruke TPU?

TPU-er i skyen er skreddersydd for bestemte applikasjoner. Du foretrekker kanskje å utføre maskinlæringsoppgavene dine ved å bruke GPUer eller CPUer i noen tilfeller. Generelt kan følgende prinsipper hjelpe deg med å vurdere om TPU er det beste alternativet for arbeidsmengden din:

- Matriseberegninger er dominerende i modellene

- Innenfor modellens hovedtreningssløyfe er det ingen tilpassede TensorFlow-operasjoner

- De er modeller som går gjennom uker eller måneder med trening

- De er massive modeller som har omfattende, effektive batchstørrelser.

La oss nå hoppe inn i noen direkte TPU vs. GPU sammenligning.

Hva er forskjellene mellom GPU og TPU?

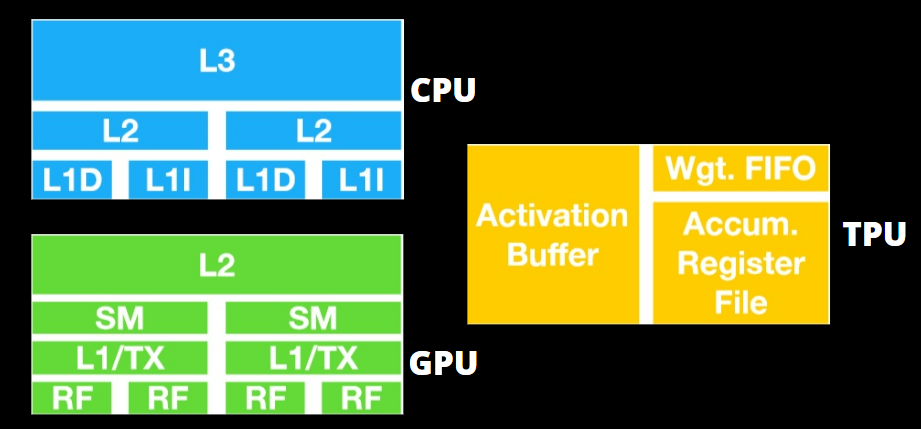

TPU vs. GPU-arkitektur

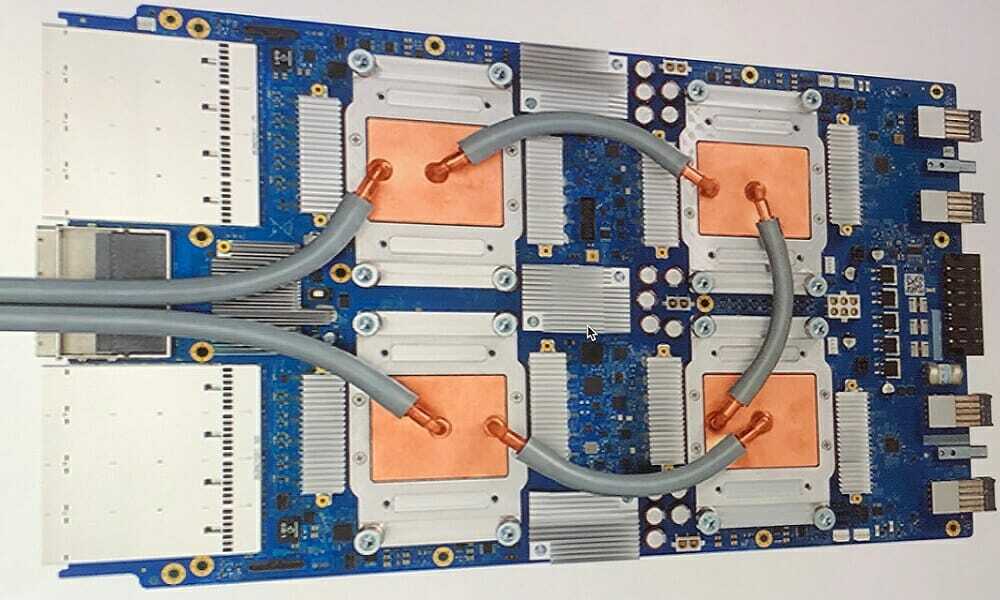

TPU er ikke svært kompleks maskinvare og føles som en signalbehandlingsmotor for radarapplikasjoner og ikke den tradisjonelle X86-avledede arkitekturen.

Til tross for at den har mange matrisemultiplikasjonsdivisjoner, er den mindre en GPU og mer en koprosessor; den utfører bare kommandoene mottatt av en vert.

Fordi det er så mange vekter å legge inn til matrisemultiplikasjonskomponenten, drives TPUs DRAM som en enkelt enhet parallelt.

I tillegg, fordi TPU-er bare kan utføre matriseoperasjoner, er TPU-kort koblet til CPU-baserte vertssystemer for å utføre oppgaver som TPU-ene ikke kan håndtere.

Vertsdatamaskinene har ansvaret for å levere data til TPU, forbehandle og hente detaljer fra Cloud Storage.

GPUer er mer opptatt av å bruke tilgjengelige kjerner på jobb enn å få tilgang til cachen med lav latens.

Mange PC-er (Processor Clusters) med flere SM-er (Streaming Multiprocessors) blir en enkelt GPU-gadget, med lag én instruksjonsbufferlag og tilhørende kjerner plassert i hver SM.

Før datautvinning fra globalt GDDR-5-minne, bruker en SM vanligvis et delt lag med to cacher og et dedikert lag med én cache. GPU-arkitekturen er tolerant for minnelatens.

En GPU opererer med et minimalt antall minnebuffernivåer. Men fordi en GPU har flere transistorer viet til prosessering, er den mindre opptatt av tiden det har å få tilgang til data i minnet.

Den mulige minnetilgangsforsinkelsen er skjult ettersom GPU-en holdes opptatt med tilstrekkelige beregninger.

TPU vs. GPU-hastighet

Denne originale TPU-generasjonen målrettet inferens, som bruker en lært modell i stedet for en trent.

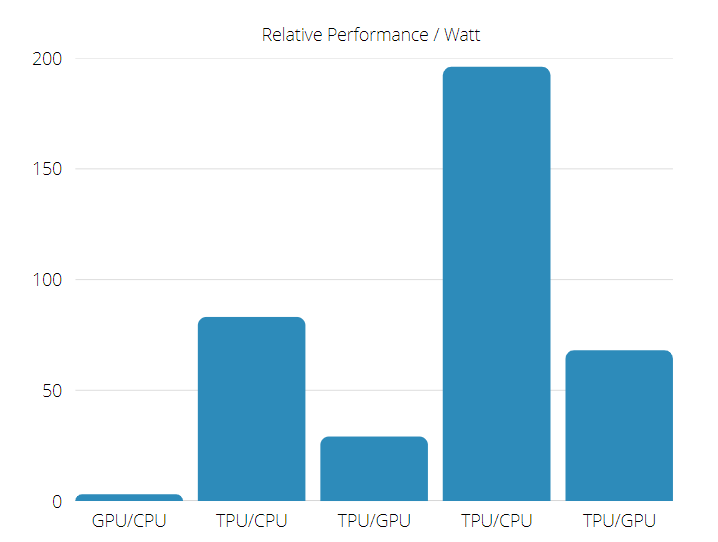

TPU er 15 til 30 ganger raskere enn nåværende GPUer og CPUer på kommersielle AI-applikasjoner som bruker nevrale nettverksslutninger.

Dessuten er TPU betydelig energieffektiv, med mellom 30 og 80 ganger økning i TOPS/Watt-verdi.

Eksperttips: Noen PC-problemer er vanskelige å takle, spesielt når det kommer til ødelagte depoter eller manglende Windows-filer. Hvis du har problemer med å fikse en feil, kan systemet ditt være delvis ødelagt. Vi anbefaler å installere Restoro, et verktøy som skanner maskinen din og identifiserer hva feilen er.

Klikk her for å laste ned og begynne å reparere.

Derfor å lage en TPU vs. Sammenligning av GPU-hastighet, oddsen er skjev mot Tensor Processing Unit.

TPU vs. GPU-ytelse

En TPU er en tensorbehandlingsmaskin laget for å øke hastigheten på Tensorflow-grafberegninger.

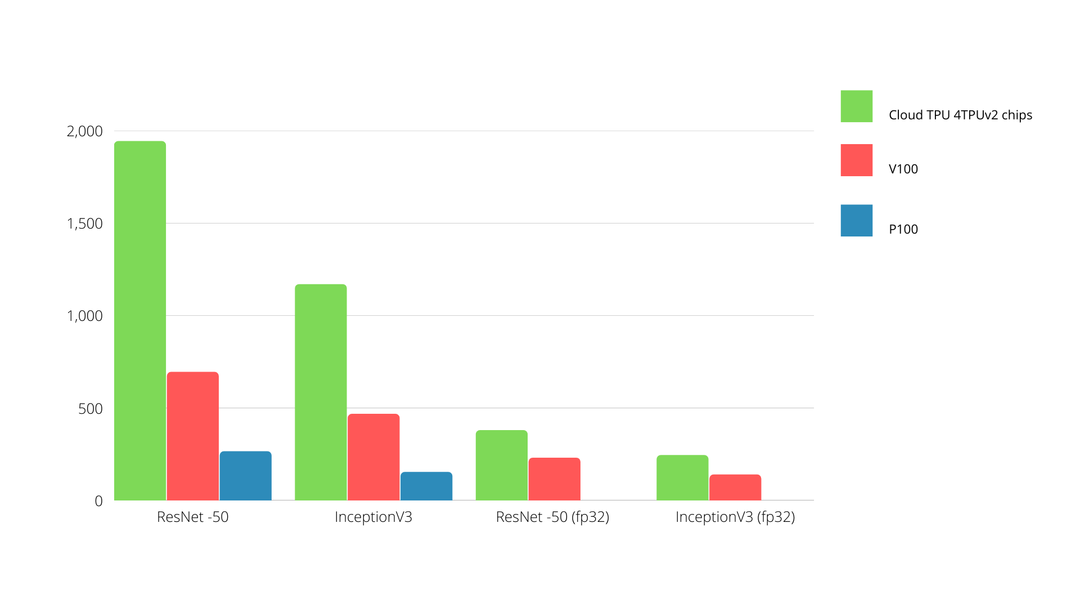

På et enkelt kort kan hver TPU gi så mye som 64 GB minne med høy båndbredde og 180 teraflops flytepunktsytelse.

En sammenligning mellom Nvidia GPUer og TPUer er vist nedenfor. Y-aksen viser antall bilder per sekund, mens X-aksen representerer de ulike modellene.

TPU vs. GPU maskinlæring

Nedenfor er treningstidene for CPUer og GPUer som bruker forskjellige batchstørrelser og iterasjoner per epoke:

- Iterasjoner/epoke: 100, Batchstørrelse: 1000, Totale epoker: 25, Parametre: 1,84 M, og modelltype: Keras Mobilenet V1 (alfa 0,75).

| AKSELERATOR | GPU (NVIDIA K80) | TPU |

| Treningsnøyaktighet (%) | 96.5 | 94.1 |

| Valideringsnøyaktighet (%) | 65.1 | 68.6 |

| Tid per iterasjon (ms) | 69 | 173 |

| Tid per epoke (e) | 69 | 173 |

| Total tid (minutter) | 30 | 72 |

- Iterasjoner/epoke: 1000, Batchstørrelse: 100, Totale epoker: 25, Parametre: 1,84 M, og modelltype: Keras Mobilenet V1 (alfa 0,75)

| AKSELERATOR | GPU (NVIDIA K80) | TPU |

| Treningsnøyaktighet (%) | 97.4 | 96.9 |

| Valideringsnøyaktighet (%) | 45.2 | 45.3 |

| Tid per iterasjon (ms) | 185 | 252 |

| Tid per epoke (e) | 18 | 25 |

| Total tid (minutter) | 16 | 21 |

Med en mindre batchstørrelse tar TPU mye lengre tid å trene, sett fra treningstiden. Imidlertid er TPU-ytelsen nærmere GPUen med økt batchstørrelse.

Derfor å lage en TPU vs. GPU-treningssammenligning, mye har med epoker og batchstørrelse å gjøre.

TPU vs. GPU benchmark

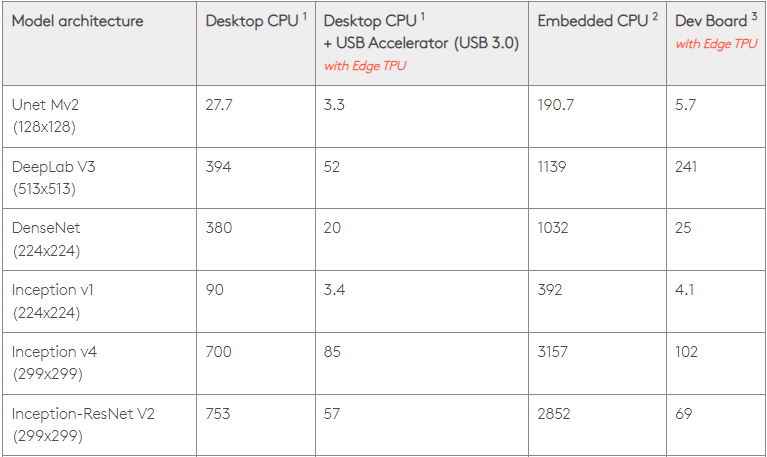

Med 0,5 watt/TOPS kan en enkelt Edge TPU utføre fire billioner operasjoner/per sekund. Flere variabler påvirker hvor godt dette oversettes til appytelse.

Nevrale nettverksmodeller har distinkte krav, og den totale utgangen varierer avhengig av vertens USB-hastighet, CPU og andre systemressurser til USB-akseleratorenheten.

Med det i tankene, kontrasterer grafikken nedenfor tid brukt på å trekke enkeltslutninger på en Edge TPU med forskjellige standardmodeller. Selvfølgelig er alle modellene som kjører TensorFlow Lite-versjonene for sammenligningens skyld.

Vær oppmerksom på at de gitte dataene ovenfor viser tiden det tar å kjøre modellen. Den ekskluderer imidlertid tiden det tar å behandle inndataene, som varierer etter applikasjon og system.

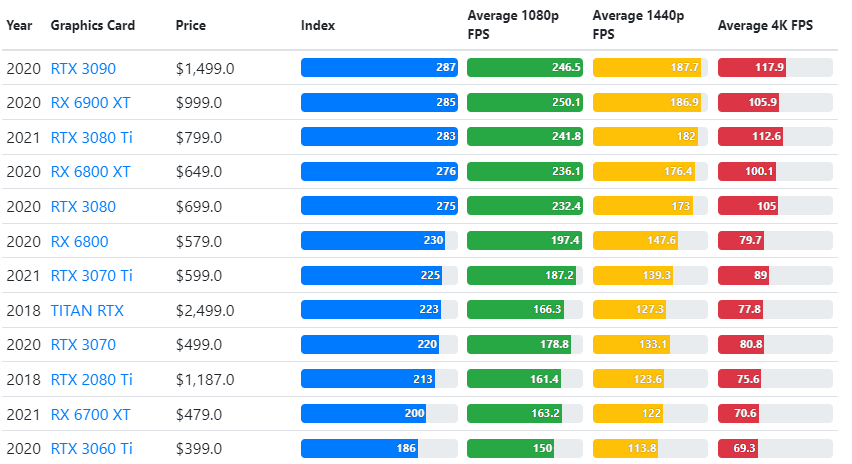

Resultatene av GPU-referanser sammenlignes med brukerens ønskede kvalitetsinnstillinger og oppløsning.

Basert på evaluering av over 70 000 benchmark-tester, har sofistikerte algoritmer blitt omhyggelig konstruert for å generere 90 prosent pålitelige estimater av spillytelse.

Selv om ytelsen til grafikkort varierer mye mellom spill, gir dette sammenligningsbildet nedenfor en bred vurderingsindeks for noen grafikkort.

- Bluetooth er nedtonet i Enhetsbehandling: 3 tips for å fikse det

- 30 tips om hvordan du åpner og kjører Windows 11s nye oppgavebehandling

- 15 beste annonsestøttede strømmetjenester [Høyest rangert]

- 5 trinn for å fikse qt5widgets.dll ikke funnet

TPU vs. GPU pris

De har en betydelig prisforskjell. TPU-er er fem ganger dyrere enn GPU-er. Her er noen eksempler:

- En Nvidia Tesla P100 GPU koster $1,46 per time

- Google TPU v3 koster $8,00 per time

- TPUv2 med GCP on-demand-tilgang $4,50 per time

Hvis målet er å optimalisere for kostnad, bør du bare gå for en TPU hvis den trener en modell 5X hastigheten til en GPU.

Hva er forskjellen mellom CPU vs. GPU vs. TPU?

Skillet mellom TPU, GPU og CPU er at CPU er en ikke-spesifikk prosessor som håndterer alle datamaskinens beregninger, logikk, input og output.

På den annen side er GPU en ekstra prosessor som brukes til å forbedre det grafiske grensesnittet (GI) og utføre avanserte aktiviteter. TPU-er er sterke, spesiallagde prosessorer som brukes til å utføre prosjekter utviklet ved hjelp av et bestemt rammeverk, for eksempel TensorFlow.

Vi kategoriserer dem som følger:

- Central Processing Unit (CPU) – Kontroller alle aspekter av en datamaskin

- Graphics Processing Unit (GPU) – Forbedre datamaskinens grafikkytelse

- Tensor Processing Unit (TPU) – ASIC er eksplisitt designet for TensorFlow-prosjekter

Lager Nvidia TPU?

Mange har lurt på hvordan NVIDIA ville reagere på Googles TPU, men vi har nå svar.

I stedet for å være bekymret, har NVIDIA vellykket deposisjonert TPU som et verktøy den kan bruke når det er fornuftig, men fortsatt holde CUDA-programvaren og GPU-ene i ledelsen.

Den beholder et kontrollpunkt for adopsjon av IoT-maskinlæring ved å gjøre teknologien åpen kildekode. Imidlertid er faren med denne metoden at den kan gi troverdighet til et konsept som kan bli en utfordring for de langsiktige ambisjonene til datasenter-slutningsmotorer for NVIDIA.

Er GPU eller TPU bedre?

Avslutningsvis må vi si at selv om vi utvikler algoritmene for å muliggjøre effektiv bruk av en TPU koster litt ekstra, de reduserte treningskostnadene oppveier generelt tilleggsprogrammeringen utgifter.

Andre grunner til å velge en TPU inkluderer det faktum at v3-128 8s G av VRAM overgår den til Nvidia GPUer, noe som gjør v3-8 til et bedre alternativ for å behandle store datasett assosiert med NLU og NLP.

Høyere hastigheter kan også føre til raskere iterasjon under utviklingssykluser, noe som fører til raskere og hyppigere innovasjon, noe som øker sannsynligheten for suksess i markedet.

TPU-en overgår GPU-en når det gjelder hastighet på innovasjon, brukervennlighet og rimelighet; forbrukere og skyarkitekter bør vurdere TPU i sine ML- og AI-initiativer.

TPU-en fra Google har rikelig med prosesseringskapasitet, og brukeren må koordinere datainndata for å sikre at det ikke er overbelastning.

Der har du det, en total TPU vs. GPU sammenligning. Vi vil gjerne vite tankene dine og se om du har gjort noen tester og hvilke resultater du fikk på TPU og GPU.

Husk at du kan nyte en oppslukende PC-opplevelse ved å bruke hvilken som helst av beste grafikkort for Windows 11.

Har du fortsatt problemer?Løs dem med dette verktøyet:

Har du fortsatt problemer?Løs dem med dette verktøyet:

- Last ned dette PC-reparasjonsverktøyet vurdert Great på TrustPilot.com (nedlastingen starter på denne siden).

- Klikk Start søk for å finne Windows-problemer som kan forårsake PC-problemer.

- Klikk Reparer alle for å fikse problemer med patentert teknologi (Eksklusiv rabatt for våre lesere).

Restoro er lastet ned av 0 lesere denne måneden.

![[Svart] Hvordan tvinger jeg et spill til å kjøre på min GPU?](/f/73a92aa41bd3d5c36899a2da2a8aa99a.png?width=300&height=460)