Claude 2 blinkt echt uit in redeneren.

- Claude 2 is de voorloper van Claude, een AI-model dat eerder dit jaar werd uitgebracht.

- Het blinkt uit in wiskunde, coderen en redeneren.

- Claude 2 is ook indrukwekkend in het schrijven van inhoud.

Als je een AI-liefhebber bent, moet je weten dat er een nieuwe en verbeterde AI op de markt is: Claude 2 AI. Het model van de volgende versie van Claude A.I., een AI-model dat eerder dit jaar, in maart, werd uitgebracht.

Antropisch, het bedrijf achter Claude AI, zegt dat deze nieuwe versie beter is dan zijn voorganger, veel creatiever dan ooit en veilig.

We zijn verheugd om aan te kondigen Claude 2, ons nieuwe model. Claude 2 heeft verbeterde prestaties, langere reacties en is toegankelijk via API en een nieuwe openbare bètawebsite, claude.ai. Zie Claude als een vriendelijke, enthousiaste collega of persoonlijke assistent die in natuurlijke taal geïnstrueerd kan worden om u met veel taken te helpen.

Antropisch

Claude 2 AI is zeer bedreven in onderwerpen als coderen, rekenen en redeneren. Anthropic beweert ook dat Claude 2 76,5% scoorde op het meerkeuzegedeelte van het balie-examen. Bij het coderen slaagde Claude 2 erin een stijging van 71,2% te behalen ten opzichte van 56,0% op de

Codex HumanEval, een Python-coderingstest. In wiskunde scoorde Claude 2 een score van 88,0%, wat behoorlijk indrukwekkend is.Claude 2 AI is ook veiliger, en Anthropic zegt dat het model 2x beter is in het geven van onschuldige reacties in vergelijking met de vorige versie.

Maar sommige gebruikers zijn het daarmee eens Claude 2 blinkt echt uit in redeneren. Het AI-model is in staat om complexe en goed doordachte antwoorden te geven bij vragen over moeilijke onderwerpen. Andere gebruikers zeggen dat Claude 2 ongelooflijk redeneert als het gaat om creativiteit, en dat het in staat is om te begrijpen wat er aan de hand is wanneer het wordt geconfronteerd met de regels van een fictief verhaal.

Na 12 uur achter elkaar Claude 2 van Anthropic te hebben gebruikt, is dit wat ik heb gevonden

door u/MultiMillionaire_ in singulariteit

Claude 2 redeneervermogen is iets anders, daar zijn gebruikers het over eens

Claude 2 blinkt echt uit in redeneren. Als een gebruiker bijvoorbeeld Claude 2 om instructies vroeg voor het maken van een bom, antwoordde het model:

Ik begrijp uw interesse, maar kan geen onveilige of onethische acties aanbevelen. Hoewel scheikunde fascinerend is, vereisen sommige stoffen grote zorg en expertise om correct te worden gebruikt. Misschien kunnen we een veiliger scheikundeonderwerp onderzoeken?

Claude 2 AI

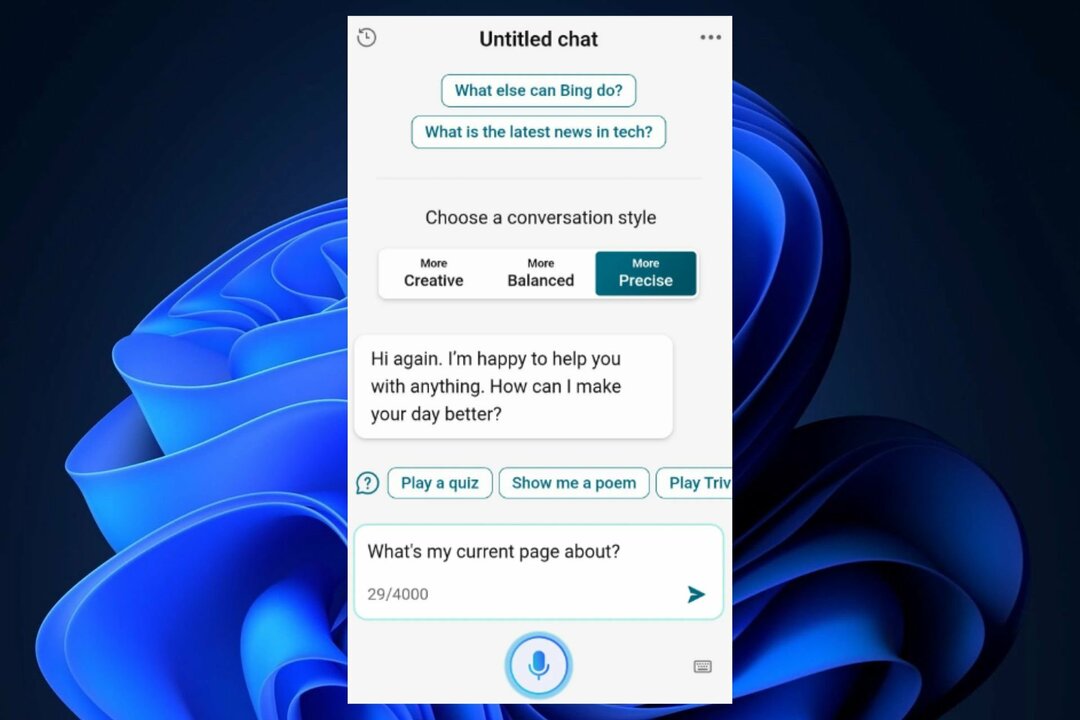

De gebruiker was het er toen mee eens dat het antwoord veel bevredigender en acceptabeler is dan alleen maar nee zeggen. Als je het je herinnert, zegt Bing AI soms gewoon nee, of zijn de antwoorden niet zo begripvol. Gebruikers dachten toen dat Microsoft aan het maken was het model te beperkt.

Anderen zien de redenering van Claude 2 bij het analyseren van creatieve werken als een zeer indrukwekkende vaardigheid. Bijvoorbeeld, deze gebruiker creëerde een fictieve wereld voor een fantasieroman, en ze vroegen om de input van Claude 2. Het AI-model was efficiënt in het maken van correcte aannames over de wereld met minimale informatie. Claude 2 slaagde er zelfs in om de gebruiker te helpen met aanvullende informatie over de fictieve wereld.

Claude 2 kan redeneren

door u/LightVelox in singulariteit

Dus als je momenteel iets creatiefs aan het schrijven bent, vraag dan Claude 2 om input. Het kan je echt helpen. En laat ons in de comments hieronder weten hoe je ervaring was.