最新の AI パートナーシップは、AI を開発するためのより安全な方法を約束します。

- この提携では今後数か月以内に顧問委員会を構成し、戦略を計画する予定だ。

- 既存の AI モデルよりも優れていると定義されるフロンティア AI モデルにのみ焦点を当てます。

- このような AI モデルを開発する組織であれば、パートナーシップに参加できます。

1週間前、 マイクロソフトがLlama 2を発表、Microsoft Inspire 2023 で Meta との AI パートナーシップについて発表。 Llama 2 は、独自の AI の構築とトレーニングに使用できるオープンソースの大規模言語モデルです。 このLLMは最初の手がかりであるとも噂されています AGIの達成に向けて、最終的には、これが AI の中心的な目標の 1 つです。

さて、発表から一週間で色々なことが起こりました。 ChatGPT を開発した OpenAI が、コードネーム G3PO という独自のオープンソース LLM をリリースするという噂もあります。 まだリリース日はありませんが、2023年か2024年にリリースされる予定です。

そして一転して、Microsoft は Anthropic、Google、Open AI と提携してフロンティア モデル フォーラムに参加したようです。 このパートナーシップは、フロンティア AI モデルの安全かつ責任ある開発を確保することに重点を置いた業界団体です。 プレスリリースによると.

本日、Anthropic、Google、Microsoft、OpenAI は、フロンティア AI モデルの安全かつ責任ある開発の確保に重点を置いた新しい業界団体であるフロンティア モデル フォーラムの設立を発表しました。 Frontier Model Forum は、メンバー企業の技術的および運用上の専門知識を活用して、AI エコシステム全体に利益をもたらします。 技術評価とベンチマークの進歩、および業界のベストプラクティスをサポートするソリューションの公開ライブラリの開発を通じて、 規格。

フロンティアモデルフォーラム

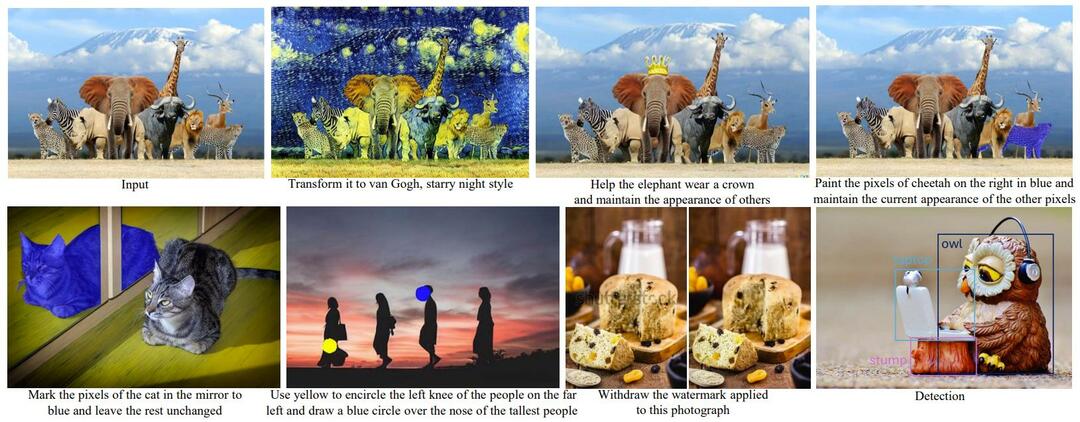

基本的に、フロンティア モデル フォーラムは、人間にとってリスクのない AI を構築したいと考えています。 覚えていると思いますが、パートナーの 1 つである Anthropic がリリースされたばかりです。

クロード2AI、そしてこのモデルは人々と安全にやりとりする方法で有名です。 したがって、Claude 2 AI に似た、あるいはおそらくそれ以上の AI が多数登場することになります。 いずれにせよ、この業界に関しては素晴らしいニュースです。AIに関してフロンティアモデルフォーラムは何をするのか

このパートナーシップは一連の中核となる目標と目的を確立しており、それらに従って機能します。 彼らです:

- AIの安全性研究の推進 フロンティアモデルの責任ある開発を促進し、リスクを最小限に抑え、機能と安全性の独立した標準化された評価を可能にします。

- ベストプラクティスの特定 フロンティア モデルの責任ある開発と展開を目的としており、テクノロジーの性質、機能、限界、影響を一般の人々が理解できるよう支援します。

- 政策立案者、学者、市民社会、企業との連携 信頼と安全のリスクに関する知識を共有するため。

- 社会の最大の課題に対処できるアプリケーションを開発する取り組みを支援、気候変動の緩和と適応、がんの早期発見と予防、サイバー脅威との闘いなど。

このパートナーシップは組織との協力も可能です

フロンティア モデル AI を開発する組織の場合は、フロンティア モデル フォーラムへの参加と共同作業を申請できます。

専門家のヒント:

スポンサーあり

PC の問題の中には、特に Windows のシステム ファイルやリポジトリが欠落または破損している場合、対処が難しいものがあります。

必ず専用ツールを使用してください。 フォルテクト、壊れたファイルをスキャンして、リポジトリからの新しいバージョンに置き換えます。

フォーラムによると、フロンティアモデル AI は、現在最も先進的な既存モデルの機能を超える大規模な機械学習モデルです。 また、さまざまなタスクを実行できる必要もあります。

パートナーシップに参加するには、組織として次の基準を満たす必要があります。

- すでにフロンティア モデル (フォーラムで定義されている) を開発および展開しています。

- この組織は、技術的および制度的アプローチを通じて、フロンティアモデルの安全性に対する強い取り組みを実証することができます。

- あなたは組織として、共同イニシアチブへの参加やイニシアチブの発展と機能の支援などを通じて、フォーラムの取り組みの推進に積極的に貢献するつもりです。

AI に関してフォーラムが行うことはこれです

Frontier Model Forum は、安全で責任ある AI 開発プロセスをサポートしたいと考えており、2023 年にかけて 3 つの主要分野に焦点を当てます。

- ベストプラクティスの特定: 幅広い潜在的なリスクを軽減するために、安全基準と安全実践に焦点を当てた知識の共有とベストプラクティスを促進します。

- AI の安全性研究の推進: AI の安全性に関する最も重要な未解決の研究課題を特定することで、AI の安全性エコシステムをサポートします。 フォーラムは、敵対的な堅牢性、 メカニズムの解釈可能性、拡張可能な監視、独立した研究へのアクセス、緊急の行動、および異常 検出。 当初は、フロンティア AI モデルの技術評価とベンチマークの公開ライブラリの開発と共有に重点が置かれます。

- 企業と政府間の情報共有の促進: AI の安全性とリスクに関する情報を企業、政府、関係者間で共有するための信頼できる安全なメカニズムを確立します。 フォーラムは、サイバーセキュリティなどの分野からの責任ある情報開示のベストプラクティスに従います。

2023 年を通じて、フロンティア モデル フォーラムは理事会の結成に取り組み、その後戦略を構築し、優先順位を確立します。 しかし、この組織はすでに民間または公的を問わず、できるだけ多くの機関と協力することを検討しています。 これには、市民社会や政府、AI に関心のあるその他の機関も含まれます。

この新しいパートナーシップについてどう思いますか? 参加することに興味がありますか? それともフロンティア AI モデルに興味がありますか? 以下のコメントセクションでお知らせください。