- テンソルプロセッシングユニットは、MLワークロードの加速に役立つ特定のアプリケーション向けの特殊な集積回路(IC)です。

- NVIDIAはGPUに重点的に取り組んでいますが、GoogleはTPUテクノロジーのパイオニアであり、この部門のリーダーです。

- TPUは、初期の追加のプログラミング費用を上回る大幅に削減されたトレーニング費用を可能にします。

バツダウンロードファイルをクリックしてインストールします

このソフトウェアは、ドライバーの稼働を維持し、一般的なコンピューターエラーやハードウェア障害からユーザーを保護します。 3つの簡単なステップで今すぐすべてのドライバーをチェックしてください:

- DriverFixをダウンロード (確認済みのダウンロードファイル)。

- クリック スキャン開始 問題のあるすべてのドライバーを見つけます。

- クリック ドライバーの更新 新しいバージョンを入手し、システムの誤動作を回避します。

- DriverFixはによってダウンロードされました 0 今月の読者。

この記事では、TPUとを作成します。 GPUの比較。 しかし、それを掘り下げる前に、ここにあなたが知っておくべきことがあります。

機械学習とAIテクノロジーは、インテリジェントアプリの成長を加速させました。 この目的のために、半導体企業は、より複雑なアプリを処理するために、TPUやCPUなどのアクセラレーターとプロセッサーを継続的に作成しています。

一部のユーザーは、TPUの使用が推奨される時期と、コンピュータータスクにGPUを使用する時期を理解するのに問題がありました。

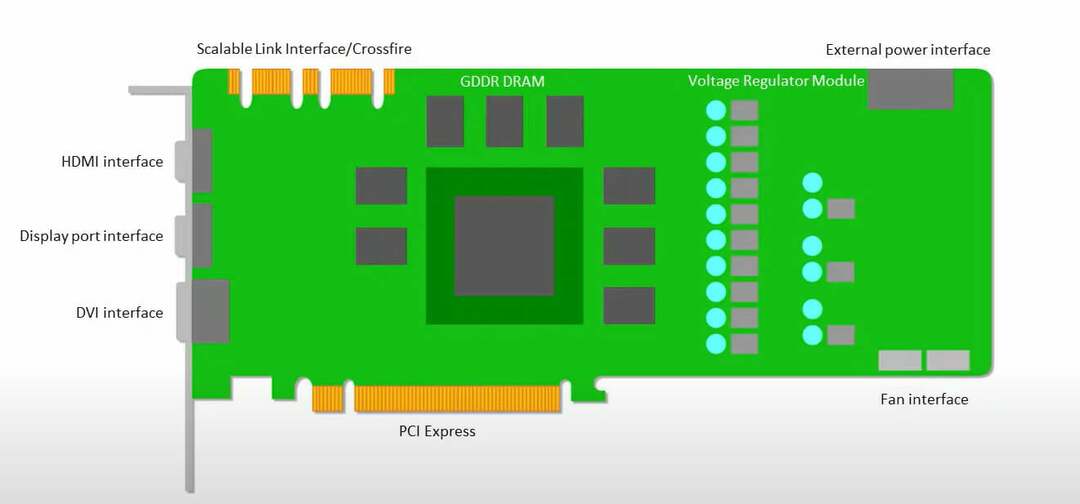

グラフィックプロセッシングユニットとも呼ばれるGPUは、視覚的で没入型のPCエクスペリエンスを提供するPCのビデオカードです。 たとえば、次の場合は簡単な手順に従うことができます PCがGPUを検出していません.

これらの状況をよりよく理解するには、TPUとは何か、GPUとの比較も明確にする必要があります。

TPUとは何ですか?

TPUまたはTensorProcessingUnitは、ASIC(特定用途向け集積回路)とも呼ばれる特定のアプリケーション向けの特殊な集積回路(IC)です。 GoogleはTPUをゼロから作成し、2015年に使用を開始し、2018年に一般公開しました。

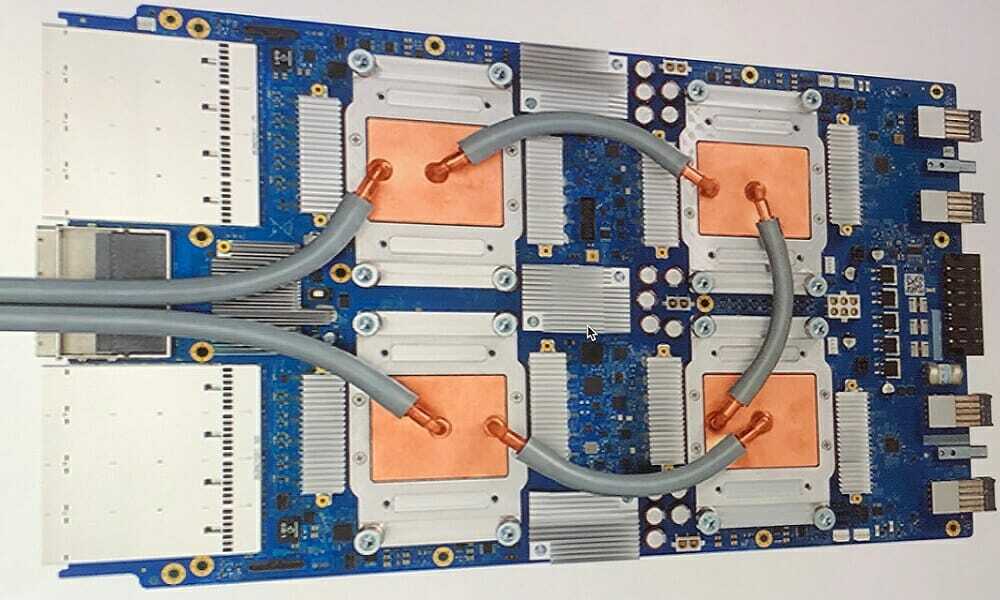

TPUは、マイナーチップまたはクラウドバージョンとして提供されます。 TensorFlowソフトウェアを使用してニューラルネットワークの機械学習を高速化するために、クラウドTPUは複雑な行列およびベクトル演算を信じられないほどの速度で解決します。

Google Brain Teamが開発したオープンソースの機械学習プラットフォームであるTensorFlowを使用すると、研究者、開発者、企業はCloudTPUハードウェアを使用してAIモデルを構築および運用できます。

複雑で堅牢なニューラルネットワークモデルをトレーニングする場合、TPUは精度値までの時間を短縮します。 これは、GPUを使用してトレーニングするのに数週間かかった可能性のある深層学習モデルがその時間のほんの一部しかかからないことを意味します。

TPUはGPUと同じですか?

それらはアーキテクチャ的に非常に明確です。 グラフィックプロセッシングユニットは、ベクトル化された数値プログラミングに向けてパイプされていますが、それ自体がプロセッサです。 GPUは、事実上、次世代のCrayスーパーコンピューターです。

TPUは、それ自体では命令を実行しないコプロセッサーです。 コードはCPUで実行され、TPUに小さな操作のフローを供給します。

いつTPUを使用する必要がありますか?

クラウド内のTPUは、特定のアプリケーションに合わせて調整されています。 場合によっては、GPUまたはCPUを使用して機械学習タスクを実行することをお勧めします。 一般に、次の原則は、TPUがワークロードに最適なオプションであるかどうかを評価するのに役立ちます。

- モデルではマトリックス計算が支配的です

- モデルのメイントレーニングループ内には、カスタムTensorFlow操作はありません

- 数週間または数か月のトレーニングを経るモデルです

- それらは、広範囲で効果的なバッチサイズを持つ大規模なモデルです。

それでは、直接TPUと GPUの比較。

GPUとTPUの違いは何ですか?

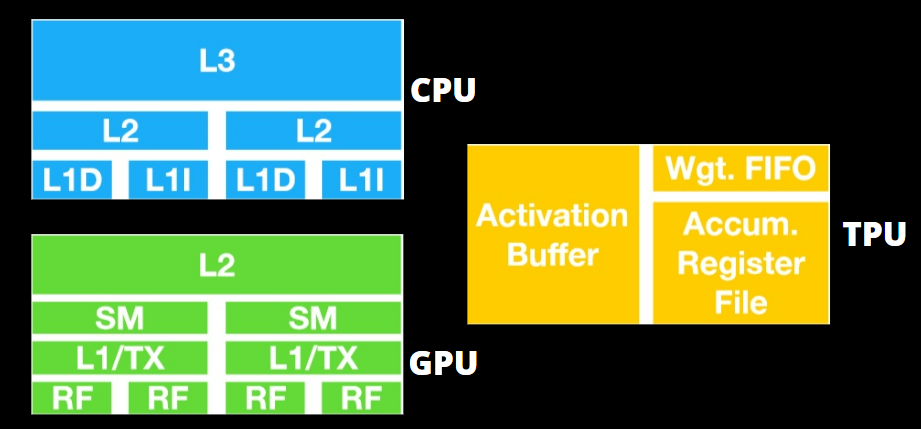

TPU対。 GPUアーキテクチャ

TPUはそれほど複雑なハードウェアではなく、レーダーアプリケーション用の信号処理エンジンのように感じられ、従来のX86から派生したアーキテクチャではありません。

多くの行列乗算除算がありますが、GPUではなく、コプロセッサーです。 ホストから受け取ったコマンドを実行するだけです。

行列乗算コンポーネントに入力する重みが非常に多いため、TPUのDRAMは単一のユニットとして並列に動作します。

さらに、TPUはマトリックス操作しか実行できないため、TPUボードはCPUベースのホストシステムにリンクされ、TPUが処理できないタスクを実行します。

ホストコンピューターは、TPUへのデータの配信、前処理、およびクラウドストレージからの詳細の取得を担当します。

GPUは、低レイテンシのキャッシュにアクセスするよりも、利用可能なコアを機能に適用することに関心があります。

複数のSM(ストリーミングマルチプロセッサ)を備えた多くのPC(プロセッサクラスター)は、単一のGPUガジェットになり、レイヤー1の命令キャッシュレイヤーとそれに付随するコアがすべてのSMに格納されます。

グローバルGDDR-5メモリからデータを抽出する前に、1つのSMは通常、2つのキャッシュの共有レイヤーと1つのキャッシュの専用レイヤーを利用します。 GPUアーキテクチャは、メモリレイテンシに耐性があります。

GPUは、最小限のメモリキャッシュレベルで動作します。 ただし、GPUは処理専用のトランジスタを多く備えているため、メモリ内のデータにアクセスする時間にはあまり関心がありません。

GPUが適切な計算で占有されているため、メモリアクセス遅延の可能性は隠されています。

TPU対。 GPU速度

このオリジナルのTPU世代は、訓練されたモデルではなく、学習されたモデルを使用する推論を対象としています。

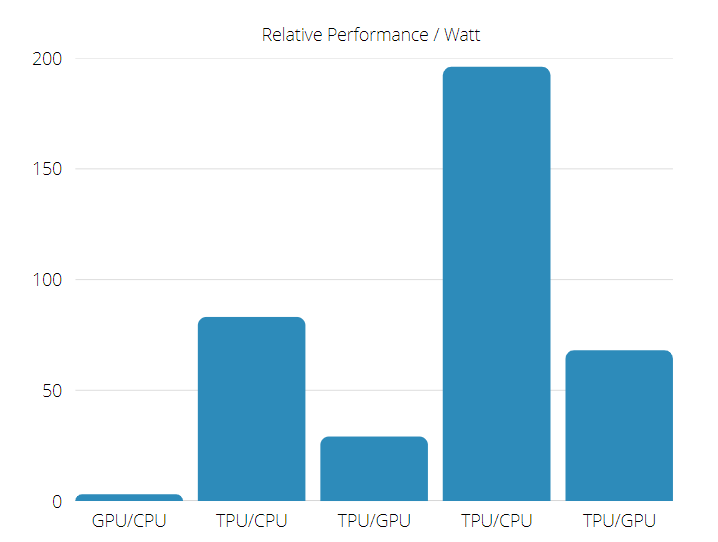

TPUは、ニューラルネットワーク推論を使用する商用AIアプリケーションの現在のGPUおよびCPUよりも15〜30倍高速です。

さらに、TPUはエネルギー効率が非常に高く、TOPS /ワット値が30〜80倍に増加します。

専門家のヒント: 一部のPCの問題は、特にリポジトリの破損やWindowsファイルの欠落に関しては対処が困難です。 エラーの修正に問題がある場合は、システムが部分的に壊れている可能性があります。 マシンをスキャンして障害を特定するツールであるRestoroをインストールすることをお勧めします。

ここをクリック ダウンロードして修復を開始します。

したがって、TPUと GPU速度の比較、オッズはテンソルプロセッシングユニットに偏っています。

TPU対。 GPUパフォーマンス

TPUは、Tensorflowグラフの計算を高速化するために作成されたテンソルプロセッシングマシンです。

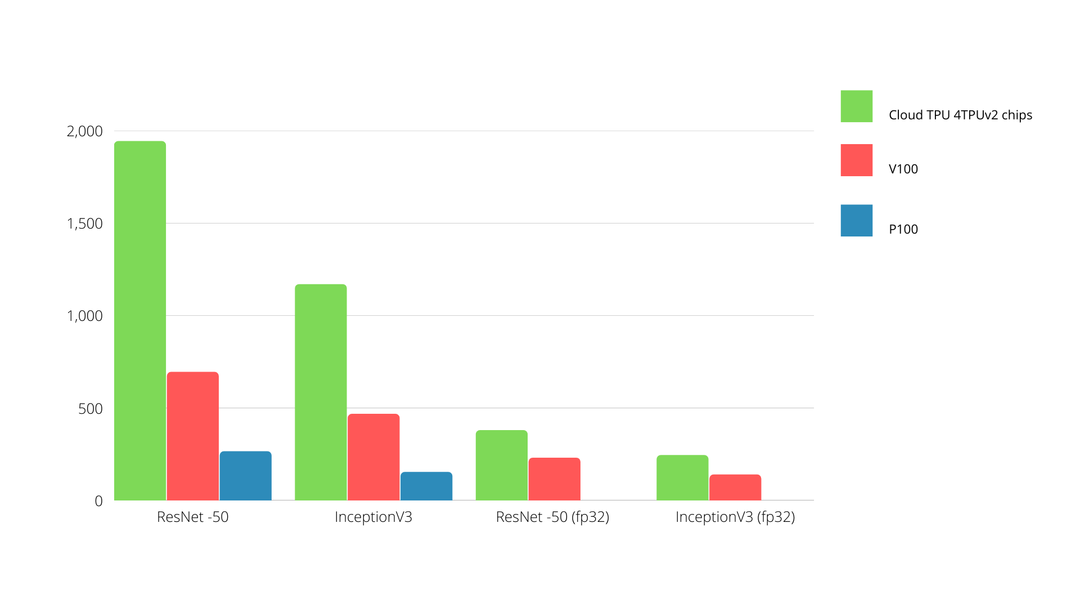

1つのボードで、各TPUは最大64GBの高帯域幅メモリと180テラフロップスの浮動小数点パフォーマンスを提供できます。

NvidiaGPUとTPUの比較を以下に示します。 Y軸は1秒あたりの写真の数を表し、X軸はさまざまなモデルを表します。

TPU対。 GPU機械学習

以下は、エポックごとに異なるバッチサイズと反復を使用したCPUとGPUのトレーニング時間です。

- 反復/エポック:100、バッチサイズ:1000、合計エポック:25、パラメーター:1.84 M、モデルタイプ:Keras Mobilenet V1(アルファ0.75)。

| アクセル | GPU(NVIDIA K80) | TPU |

| トレーニング精度(%) | 96.5 | 94.1 |

| 検証精度(%) | 65.1 | 68.6 |

| 反復あたりの時間(ミリ秒) | 69 | 173 |

| エポックあたりの時間(s) | 69 | 173 |

| 合計時間(分) | 30 | 72 |

- 反復/エポック:1000、バッチサイズ:100、合計エポック:25、パラメーター:1.84 M、モデルタイプ:Keras Mobilenet V1(アルファ0.75)

| アクセル | GPU(NVIDIA K80) | TPU |

| トレーニング精度(%) | 97.4 | 96.9 |

| 検証精度(%) | 45.2 | 45.3 |

| 反復あたりの時間(ミリ秒) | 185 | 252 |

| エポックあたりの時間(s) | 18 | 25 |

| 合計時間(分) | 16 | 21 |

バッチサイズが小さいと、トレーニング時間からわかるように、TPUのトレーニングにかかる時間が大幅に長くなります。 ただし、TPUのパフォーマンスは、バッチサイズが大きくなるとGPUに近くなります。

したがって、TPUと GPUトレーニングの比較では、多くのことがエポックとバッチサイズに関係しています。

TPU対。 GPUベンチマーク

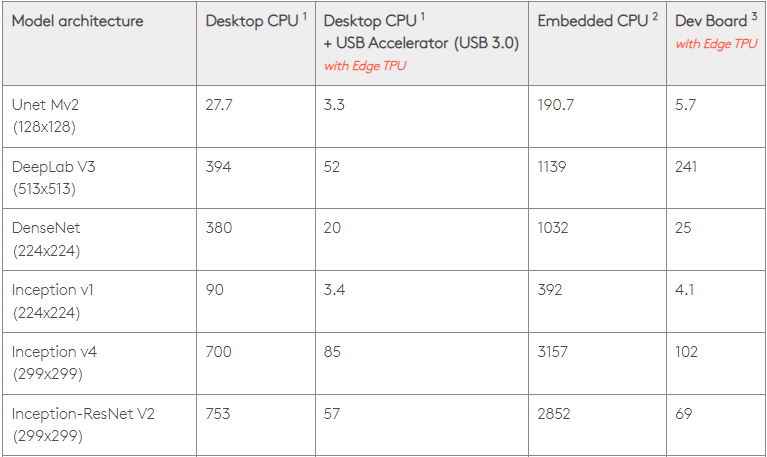

0.5ワット/TOPSの場合、1つのエッジTPUで1秒あたり4兆回の操作を実行できます。 いくつかの変数は、これがアプリのパフォーマンスにどれだけうまく変換されるかに影響します。

ニューラルネットワークモデルには明確な要件があり、全体的な出力は、ホストのUSB速度、CPU、およびUSBアクセラレータデバイスの他のシステムリソースによって異なります。

そのことを念頭に置いて、下の図は、さまざまな標準モデルを使用してEdgeTPUで単一の推論を行うために費やされた時間を対比しています。 もちろん、実行中のすべてのモデルは、比較のためにTensorFlowLiteバージョンです。

上記のデータは、モデルの実行にかかる時間を示していることに注意してください。 ただし、アプリケーションやシステムによって異なる入力データの処理にかかる時間は除外されています。

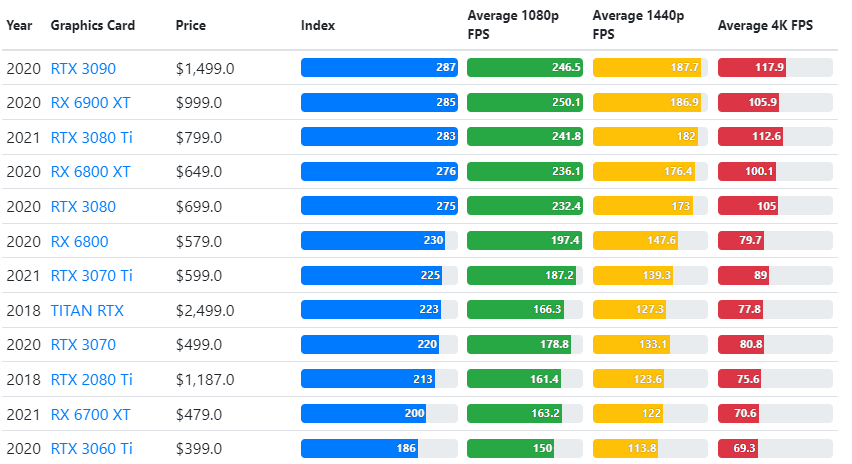

GPUベンチマークの結果は、ユーザーの希望するゲームプレイ品質設定および解像度と比較されます。

70,000以上のベンチマークテストの評価に基づいて、ゲームパフォーマンスの90%の信頼性の高い推定値を生成するために、高度なアルゴリズムが細心の注意を払って構築されています。

グラフィックカードのパフォーマンスはゲームによって大きく異なりますが、以下のこの比較画像は、一部のグラフィックカードの幅広い評価指標を示しています。

- Bluetoothがデバイスマネージャーでグレー表示される:それを修正するための3つのヒント

- Windows11の新しいタスクマネージャを開いて実行する方法に関する30のヒント

- 15の最高の広告サポートストリーミングサービス[最高評価]

- qt5widgets.dllが見つからない問題を修正する5つの手順

TPU対。 GPU価格

それらには大きな価格差があります。 TPUはGPUの5倍のコストがかかります。 ここではいくつかの例を示します。

- Nvidia TeslaP100GPUの価格は1時間あたり1.46ドルです

- GoogleTPUv3の料金は1時間あたり$8.00です

- GCPオンデマンドアクセスを備えたTPUv2は1時間あたり4.50ドル

コストの最適化が目的である場合は、GPUの5倍の速度でモデルをトレーニングする場合にのみTPUを選択する必要があります。

CPUとの違いは何ですか。 GPUと TPU?

TPU、GPU、およびCPUの違いは、CPUが、コンピューターのすべての計算、ロジック、入力、および出力を処理する非特定目的のプロセッサーであることです。

一方、GPUは、グラフィカルインターフェイス(GI)を改善し、ハイエンドのアクティビティを実行するために使用される追加のプロセッサです。 TPUは、TensorFlowなどの特定のフレームワークを使用して開発されたプロジェクトを実行するために使用される、強力な特別に作成されたプロセッサです。

それらを次のように分類します。

- 中央処理装置(CPU)–コンピューターのすべての側面を制御します

- グラフィックスプロセッシングユニット(GPU)–コンピューターのグラフィックスパフォーマンスを向上させる

- Tensor Processing Unit(TPU)–TensorFlowプロジェクト用に明示的に設計されたASIC

NvidiaはTPUを作成しますか?

多くの人がNVIDIAがGoogleのTPUにどのように反応するのか疑問に思っていましたが、今では答えがあります。

NVIDIAは、心配するのではなく、TPUを、理にかなったときに利用できるツールとして配置することに成功しましたが、それでもCUDAソフトウェアとGPUをリードしています。

テクノロジーをオープンソースにすることで、IoT機械学習の採用のコントロールポイントを維持します。 ただし、この方法の危険性は、NVIDIAのデータセンター推論エンジンの長期的な願望に対する課題となる可能性のある概念に信頼を与える可能性があることです。

GPUまたはTPUのどちらが優れていますか?

結論として、アルゴリズムを開発しているにもかかわらず、 TPUのコストは少し余分ですが、トレーニングコストの削減は、通常、追加のプログラミングを上回ります。 費用。

TPUを選択するその他の理由には、v3-1288のVRAMのGが Nvidia GPU、v3-8をNLUに関連付けられた大規模なデータセットを処理するためのより良い代替手段にします およびNLP。

速度が速いと、開発サイクル中の反復が速くなり、イノベーションがより速く、より頻繁になり、市場で成功する可能性が高くなります。

TPUは、イノベーションの速度、使いやすさ、手頃な価格の点でGPUよりも優れています。 消費者とクラウドアーキテクトは、MLおよびAIイニシアチブでTPUを検討する必要があります。

GoogleのTPUには十分な処理能力があり、ユーザーはデータ入力を調整して過負荷がないことを確認する必要があります。

これで、合計TPUと GPUの比較。 私たちはあなたの考えを知り、あなたがテストを行ったかどうか、そしてTPUとGPUでどのような結果が得られたかを確認したいと思います。

いずれかを使用して、没入型PCエクスペリエンスを楽しむことができることを忘れないでください。 Windows11に最適なグラフィックカード.

まだ問題がありますか?このツールでそれらを修正します:

まだ問題がありますか?このツールでそれらを修正します:

- このPC修復ツールをダウンロードする TrustPilot.comで素晴らしいと評価されました (ダウンロードはこのページから始まります)。

- クリック スキャン開始 PCの問題を引き起こしている可能性のあるWindowsの問題を見つけるため。

- クリック 全て直す 特許技術の問題を修正する (読者限定割引)。

Restoroはによってダウンロードされました 0 今月の読者。

![ゲームに最適な4枚のグラフィックカード[サイバーマンデー、BF]](/f/c99abe8d53ff7753c96687978e4d5579.jpeg?width=300&height=460)