phi-1 adalah model bahasa baru Microsoft untuk pengkodean.

- Microsoft mendanai banyak penelitian AI.

- Setelah mengumumkan bahwa Orca akan menjadi open source, phi-1 juga hadir.

- phi-1 mampu mengkonsolidasikan pengetahuan sendiri.

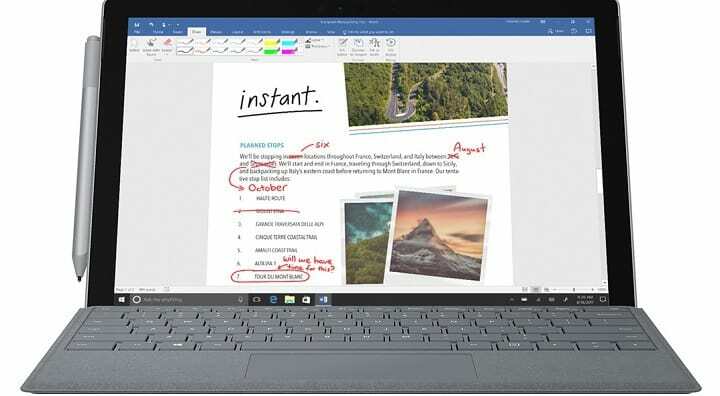

Microsoft benar-benar mengambil langkah besar dalam pengembangan AI. Bulan lalu, AI berada di garis depan konferensi Microsoft Build, dan teknologi yang berbasis di Redmond bahkan mengumumkannya Kopilot akan hadir di Windows 11. Sebagai aplikasi bawaan asli, untuk semua yang Anda butuhkan,

AI juga akan hadir di Microsoft Teams, dalam alat Rekap Ai-nya. Dan banyak alat lain dari Microsoft akan menggunakan AI, termasuk Microsoft Fabric.

Namun tampaknya, Microsoft juga mendanai penelitian AI. Baru-baru ini, raksasa teknologi itu mengumumkan Orca 13B akan menjadi open source. Dan LongMem adalah poin bagus lainnya dalam penelitian AI: itu adalah jawaban untuk panjang konteks tak terbatas.

Dan sekarang saatnya untuk terobosan besar lainnya dalam penelitian AI, tentu saja datang dari Microsoft. LLM pengkodean model 1.3B-parameter baru, yang disebut phi-1, dilaporkan mengungguli GPT 3.5, hanya dalam 4 hari pelatihan.

Apa itu phi-1 dan bagaimana kinerjanya mengungguli GPT?

Phi-1 adalah model bahasa parameter 1.3B baru untuk kode, dengan ukuran yang jauh lebih kecil daripada model pesaing. Model bahasa dilatih selama 4 hari, lebih dari 7 miliar token (sedikit lebih dari 50 miliar total token yang terlihat) diikuti dengan penyempurnaan pada kurang dari 200 juta token.

Meskipun jauh lebih kecil dari model pesaing, phi-1 mencapai 50,6% [email dilindungi] akurasi pada HumanEval dan 55,5% [email dilindungi] akurasi pada MBPP (Sebagian Besar Program Python Dasar), yang merupakan salah satu angka yang dilaporkan sendiri terbaik hanya menggunakan satu generasi LLM.

Selain itu, meskipun dilatih dengan token yang jauh lebih sedikit dibandingkan dengan model yang ada, phi-1 masih memiliki banyak potensi.

Peningkatan pada HumanEval adalah pencapaian terbesar phi-1, sebagai model bahasa. Setelah penyetelan, phi-1 berhasil menjalankan tugas yang tidak ditampilkan dalam kumpulan data penyetelan. Ini berarti model mengadaptasi dan meningkatkan proses fine-tuning.

Dan hal yang paling luar biasa adalah bahwa phi-1 mengatur ulang dan mengkonsolidasikan pengetahuan yang diperoleh selama pra-pelatihan, meskipun pengetahuan tersebut tidak secara eksplisit hadir di sana sejak awal.

Singkatnya, phi-1 tidak hanya belajar selama pelatihan tetapi juga memperluas pengetahuannya sendiri. Itu berhasil mengungguli GPT 3.5 di setiap level, dan hanya masalah waktu sampai model kecil mengalahkan yang besar, seperti GPT 4.

Apa pendapat Anda tentang model AI baru ini? Menurut Anda, kemana arah penelitian AI? Pastikan untuk memberi tahu kami pendapat Anda di bagian komentar di bawah.