- Les unités de traitement de tenseur sont des circuits intégrés (CI) spécialisés pour des applications spécifiques utiles pour accélérer les charges de travail ML.

- Alors que NVIDIA concentre ses efforts sur les GPU, Google a été le pionnier de la technologie TPU et est le leader dans ce domaine.

- Les TPU permettent un coût de formation très réduit qui l'emporte sur les dépenses de programmation supplémentaires initiales.

XINSTALLER EN CLIQUANT SUR LE FICHIER DE TÉLÉCHARGEMENT

Ce logiciel maintiendra vos pilotes opérationnels, vous protégeant ainsi des erreurs informatiques courantes et des pannes matérielles. Vérifiez tous vos pilotes maintenant en 3 étapes faciles :

- Télécharger DriverFix (fichier de téléchargement vérifié).

- Cliquez sur Lancer l'analyse pour trouver tous les pilotes problématiques.

- Cliquez sur Mettre à jour les pilotes pour obtenir de nouvelles versions et éviter les dysfonctionnements du système.

- DriverFix a été téléchargé par 0 lecteurs ce mois-ci.

Dans cet article, nous allons faire un TPU vs. Comparaison GPU. Mais avant de nous y plonger, voici ce que vous devez savoir.

L'apprentissage automatique et la technologie de l'IA ont accéléré la croissance des applications intelligentes. À cette fin, les entreprises de semi-conducteurs créent continuellement des accélérateurs et des processeurs, y compris des TPU et des CPU, pour gérer des applications plus complexes.

Certains utilisateurs ont eu des problèmes pour comprendre quand il est recommandé d'utiliser un TPU et quand utiliser un GPU pour leurs tâches informatiques.

Un GPU, également connu sous le nom d'unité de traitement graphique, est la carte vidéo de votre PC pour vous offrir une expérience PC visuelle et immersive. Par exemple, vous pouvez suivre des étapes simples si votre Le PC ne détecte pas le GPU.

Pour mieux comprendre ces circonstances, nous devrons également clarifier ce qu'est un TPU et comment il se compare à un GPU.

Qu'est-ce qu'un TPU ?

Les TPU ou Tensor Processing Units sont des circuits intégrés (CI) spécialisés pour des applications spécifiques, également appelés ASIC (circuits intégrés spécifiques à une application). Google a créé des TPU à partir de zéro, a commencé à les utiliser en 2015 et les a ouverts au public en 2018.

Les TPU sont proposés sous forme de puces mineures ou de versions cloud. Pour accélérer l'apprentissage automatique d'un réseau de neurones à l'aide du logiciel TensorFlow, les TPU cloud résolvent des opérations matricielles et vectorielles complexes à des vitesses incroyables.

Avec TensorFlow, l'équipe Google Brain a développé une plate-forme d'apprentissage automatique open source, les chercheurs, les développeurs et les entreprises peuvent construire et exploiter des modèles d'IA à l'aide du matériel Cloud TPU.

Lors de la formation de modèles de réseaux neuronaux complexes et robustes, les TPU réduisent le délai de précision. Cela signifie que les modèles d'apprentissage en profondeur qui peuvent avoir mis des semaines à s'entraîner à l'aide de GPU prennent moins d'une fraction de ce temps.

Le TPU est-il identique au GPU ?

Ils sont architecturalement très distincts. Une unité de traitement graphique est un processeur en soi, même s'il est orienté vers la programmation numérique vectorisée. Les GPU sont, en effet, la prochaine génération des supercalculateurs Cray.

Les TPU sont des coprocesseurs qui n'exécutent pas d'instructions par eux-mêmes; le code est exécuté sur les processeurs, ce qui alimente le TPU en un flux de petites opérations.

Quand dois-je utiliser le TPU ?

Les TPU dans le cloud sont adaptés à des applications particulières. Vous préférerez peut-être exécuter vos tâches d'apprentissage automatique à l'aide de GPU ou de CPU dans certains cas. En général, les principes suivants peuvent vous aider à évaluer si le TPU est la meilleure option pour votre charge de travail :

- Les calculs matriciels sont dominants dans les modèles

- Dans la boucle d'entraînement principale du modèle, il n'y a pas d'opérations TensorFlow personnalisées

- Ce sont des modèles qui passent des semaines ou des mois d'entraînement

- Ce sont des modèles massifs qui ont des tailles de lot étendues et efficaces.

Passons maintenant à certains directs TPU vs. Comparaison GPU.

Quelles sont les différences entre GPU et TPU?

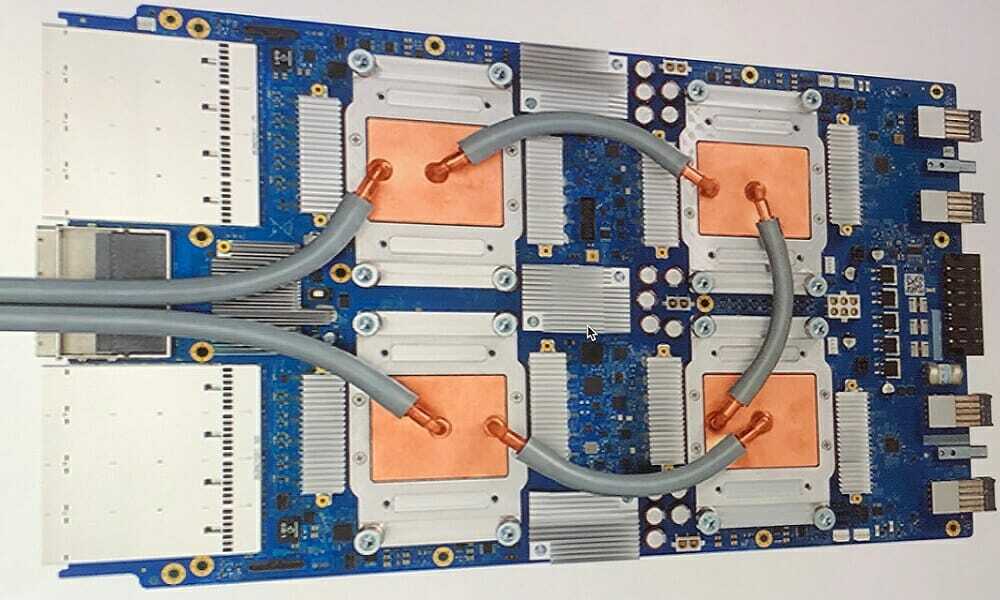

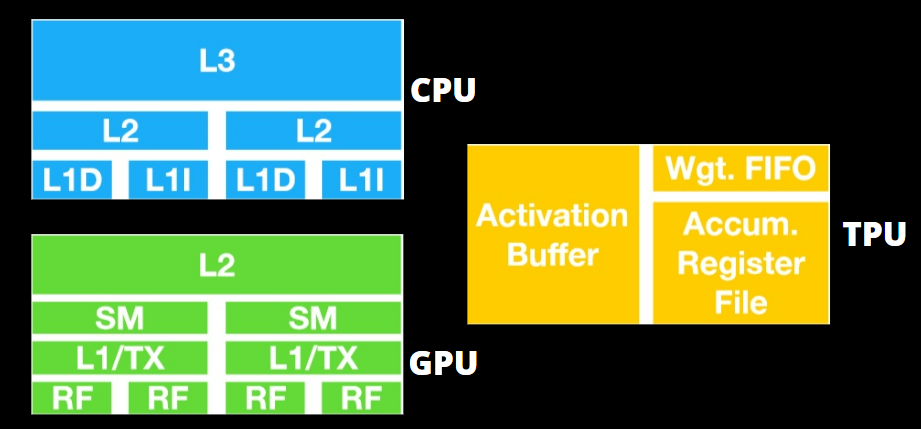

TPU contre Architecture GPU

Le TPU n'est pas un matériel très complexe et ressemble à un moteur de traitement du signal pour les applications radar et non à l'architecture traditionnelle dérivée du X86.

Malgré ses nombreuses divisions de multiplication matricielle, il s'agit moins d'un GPU que d'un coprocesseur; il exécute simplement les commandes reçues données par un hôte.

Parce qu'il y a tellement de poids à entrer dans le composant de multiplication matricielle, la DRAM du TPU fonctionne comme une seule unité en parallèle.

De plus, étant donné que les TPU ne peuvent effectuer que des opérations matricielles, les cartes TPU sont liées à des systèmes hôtes basés sur CPU pour accomplir des tâches que les TPU ne peuvent pas gérer.

Les ordinateurs hôtes sont chargés de transmettre les données au TPU, de les prétraiter et de récupérer les détails à partir de Cloud Storage.

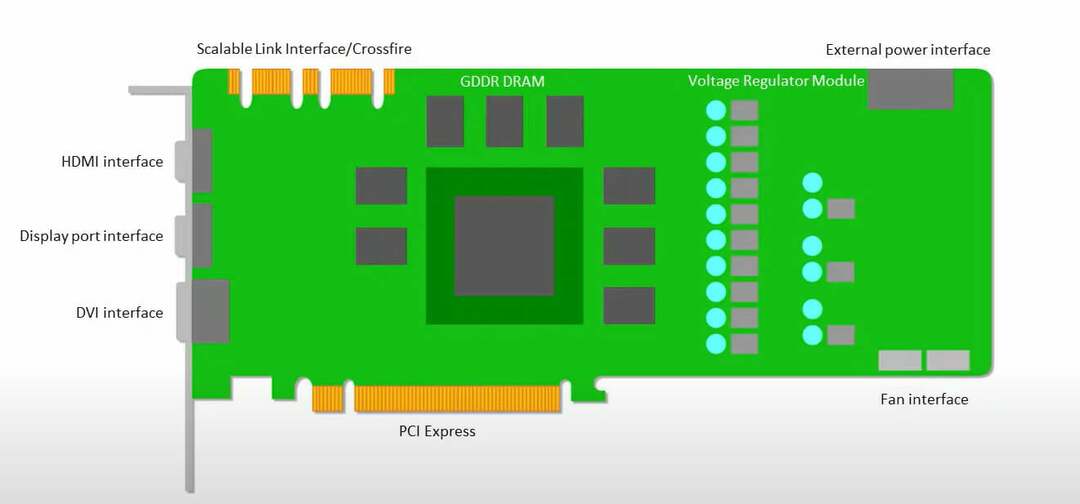

Les GPU sont plus soucieux d'appliquer les cœurs disponibles au travail que d'accéder au cache à faible latence.

De nombreux PC (grappes de processeurs) avec plusieurs SM (multiprocesseurs de diffusion en continu) deviennent un seul gadget GPU, avec des couches de cache d'instructions de couche un et des cœurs associés hébergés dans chaque SM.

Avant l'extraction des données de la mémoire GDDR-5 globale, un SM utilise généralement une couche partagée de deux caches et une couche dédiée d'un cache. L'architecture GPU est tolérante à la latence de la mémoire.

Un GPU fonctionne avec un nombre minimal de niveaux de cache mémoire. Cependant, comme un GPU comporte plus de transistors dédiés au traitement, il est moins concerné par son temps d'accès aux données dans la mémoire.

L'éventuel retard d'accès à la mémoire est caché car le GPU est occupé par des calculs adéquats.

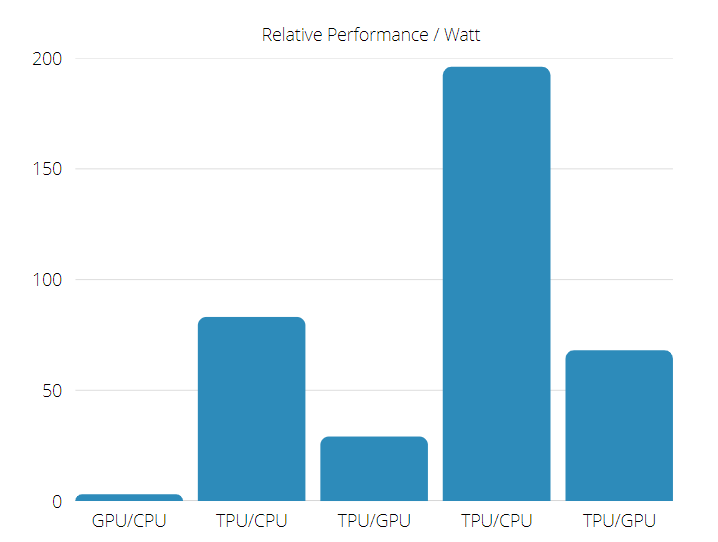

TPU contre Vitesse du processeur graphique

Cette génération originale de TPU a ciblé l'inférence, qui utilise un modèle appris plutôt qu'un modèle formé.

Le TPU est 15 à 30 fois plus rapide que les GPU et CPU actuels sur les applications d'IA commerciales qui utilisent l'inférence de réseau neuronal.

De plus, le TPU est considérablement économe en énergie, avec une augmentation de 30 à 80 fois de la valeur TOPS/Watt.

Conseil d'expert: Certains problèmes de PC sont difficiles à résoudre, en particulier lorsqu'il s'agit de référentiels corrompus ou de fichiers Windows manquants. Si vous rencontrez des problèmes pour corriger une erreur, votre système peut être partiellement endommagé. Nous vous recommandons d'installer Restoro, un outil qui analysera votre machine et identifiera le problème.

Cliquez ici pour télécharger et commencer à réparer.

Par conséquent, en faisant un TPU vs. Comparaison de la vitesse du GPU, les chances sont biaisées en faveur de l'unité de traitement du tenseur.

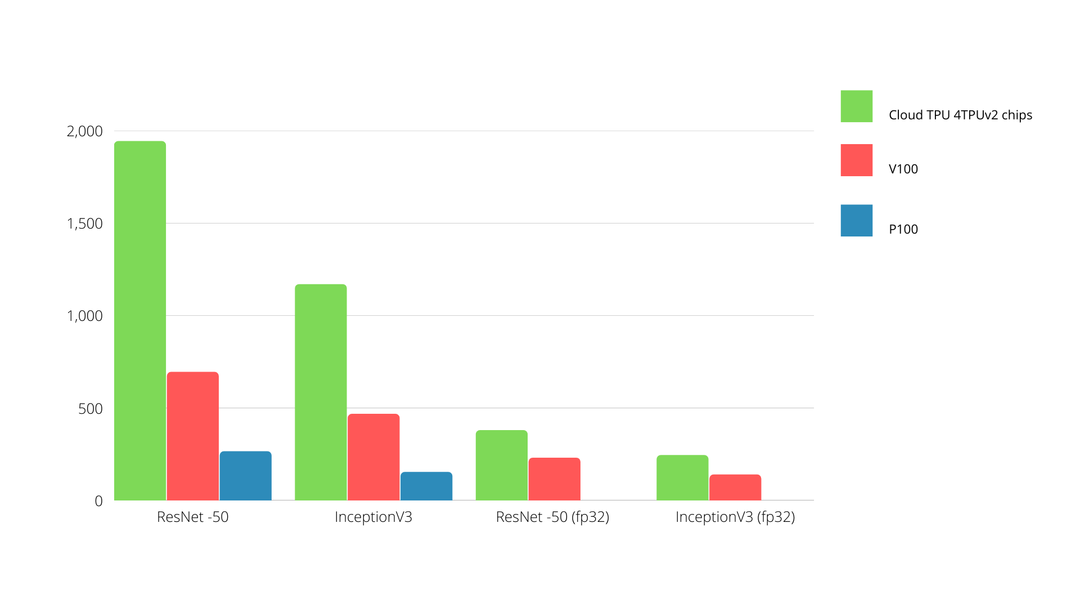

TPU contre Performances du processeur graphique

Un TPU est une machine de traitement de tenseurs créée pour accélérer les calculs de graphes Tensorflow.

Sur une seule carte, chaque TPU peut fournir jusqu'à 64 Go de mémoire à large bande passante et 180 téraflops de performances en virgule flottante.

Une comparaison entre les GPU Nvidia et les TPU est présentée ci-dessous. L'axe Y représente le nombre de photos par seconde, tandis que l'axe X représente les différents modèles.

TPU contre Apprentissage automatique GPU

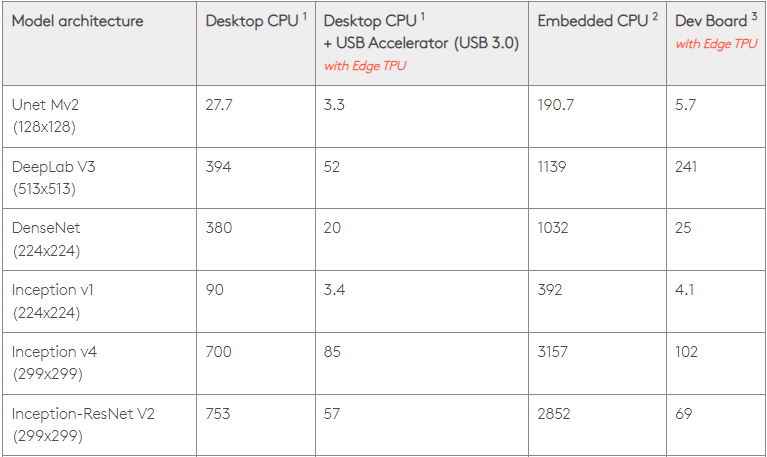

Vous trouverez ci-dessous les temps de formation pour les CPU et les GPU utilisant différentes tailles de lot et itérations par époque:

- Itérations/époque: 100, Taille du lot: 1000, Nombre total d'époques: 25, Paramètres: 1,84 M et Type de modèle: Keras Mobilenet V1 (alpha 0,75).

| ACCÉLÉRATEUR | GPU (NVIDIA K80) | TPU |

| Précision de la formation (%) | 96.5 | 94.1 |

| Précision de validation (%) | 65.1 | 68.6 |

| Temps par itération (ms) | 69 | 173 |

| Temps par époque (s) | 69 | 173 |

| Durée totale (minutes) | 30 | 72 |

- Itérations/époque: 1000, Taille du lot: 100, Nombre total d'époques: 25, Paramètres: 1,84 M et Type de modèle: Keras Mobilenet V1 (alpha 0,75)

| ACCÉLÉRATEUR | GPU (NVIDIA K80) | TPU |

| Précision de la formation (%) | 97.4 | 96.9 |

| Précision de validation (%) | 45.2 | 45.3 |

| Temps par itération (ms) | 185 | 252 |

| Temps par époque (s) | 18 | 25 |

| Durée totale (minutes) | 16 | 21 |

Avec une taille de lot plus petite, le TPU prend beaucoup plus de temps à s'entraîner, comme le montre le temps d'entraînement. Cependant, les performances du TPU sont plus proches du GPU avec une taille de lot accrue.

Par conséquent, en faisant un TPU vs. Comparaison de la formation GPU, beaucoup a à voir avec les époques et la taille des lots.

TPU contre Référence GPU

Avec 0,5 watt/TOPS, un seul Edge TPU peut exécuter quatre billions d'opérations/par seconde. Plusieurs variables influencent la façon dont cela se traduit par les performances de l'application.

Les modèles de réseau neuronal ont des exigences distinctes et la sortie globale varie en fonction de la vitesse de l'USB hôte, du processeur et des autres ressources système du périphérique accélérateur USB.

Dans cet esprit, le graphique ci-dessous compare le temps passé à faire des inférences uniques sur un Edge TPU avec divers modèles standard. Bien sûr, tous les modèles en cours d'exécution sont les versions TensorFlow Lite à titre de comparaison.

Veuillez noter que les données ci-dessus indiquent le temps nécessaire pour exécuter le modèle. Cependant, cela exclut le temps nécessaire au traitement des données d'entrée, qui varie selon l'application et le système.

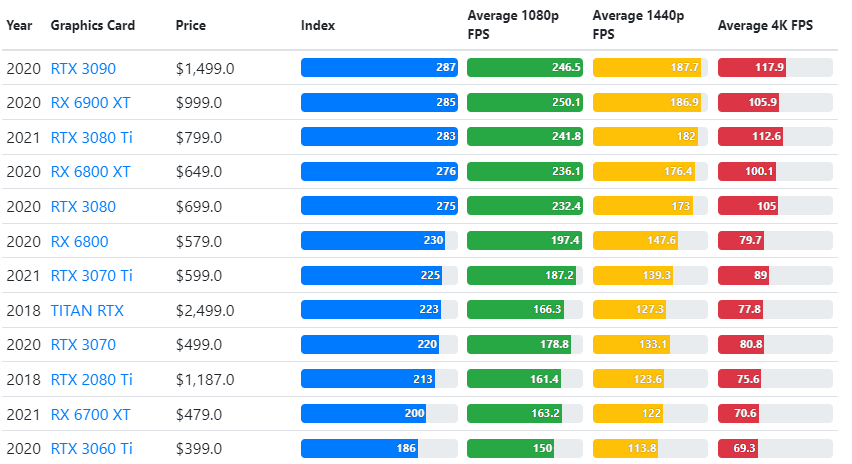

Les résultats des benchmarks GPU sont comparés aux paramètres de qualité de jeu et à la résolution souhaités par l'utilisateur.

Basés sur l'évaluation de plus de 70 000 tests de référence, des algorithmes sophistiqués ont été méticuleusement construits pour générer des estimations fiables à 90 % des performances de jeu.

Bien que les performances des cartes graphiques varient considérablement d'un jeu à l'autre, cette image de comparaison ci-dessous donne un large indice de notation pour certaines cartes graphiques.

- Bluetooth est grisé dans le Gestionnaire de périphériques: 3 astuces pour y remédier

- 30 conseils pour ouvrir et exécuter le nouveau gestionnaire de tâches de Windows 11

- 15 meilleurs services de streaming financés par la publicité [Les mieux notés]

- 5 étapes pour réparer qt5widgets.dll introuvable

TPU contre Prix du GPU

Ils ont une différence de prix importante. Les TPU sont cinq fois plus chers que les GPU. Voici quelques exemples:

- Un GPU Nvidia Tesla P100 coûte 1,46 $ par heure

- Google TPU v3 coûte 8,00 $ par heure

- TPUv2 avec accès à la demande GCP 4,50 $ de l'heure

Si l'objectif est d'optimiser les coûts, vous ne devriez opter pour un TPU que s'il entraîne un modèle 5 fois plus rapide qu'un GPU.

Quelle est la différence entre CPU vs. GPU contre TPU ?

La distinction entre le TPU, le GPU et le CPU est que le CPU est un processeur non spécifique qui gère tous les calculs, la logique, les entrées et les sorties de l'ordinateur.

D'autre part, le GPU est un processeur supplémentaire utilisé pour améliorer l'interface graphique (GI) et effectuer des activités haut de gamme. Les TPU sont des processeurs puissants et spécialement conçus pour exécuter des projets développés à l'aide d'un framework particulier, tel que TensorFlow.

Nous les classons comme suit :

- Unité centrale de traitement (CPU) - Contrôlez tous les aspects d'un ordinateur

- Unité de traitement graphique (GPU) - Améliorer les performances graphiques de l'ordinateur

- Tensor Processing Unit (TPU) - ASIC explicitement conçu pour les projets TensorFlow

Nvidia fabrique-t-il du TPU ?

Beaucoup de gens se sont demandé comment NVIDIA réagirait au TPU de Google, mais nous avons maintenant des réponses.

Plutôt que de s'inquiéter, NVIDIA a réussi à dépositionner le TPU comme un outil qu'il peut utiliser quand cela a du sens tout en gardant son logiciel CUDA et ses GPU en tête.

Il garde un point de contrôle pour l'adoption de l'apprentissage automatique IoT en rendant la technologie open source. Cependant, le danger de cette méthode est qu'elle peut donner du crédit à un concept qui pourrait devenir un défi pour les aspirations à long terme des moteurs d'inférence de centre de données pour NVIDIA.

Le GPU ou le TPU sont-ils meilleurs ?

En conclusion, nous devons dire que bien que développant les algorithmes permettant l'utilisation efficace d'un Le TPU coûte un peu plus cher, les coûts de formation réduits l'emportent généralement sur la programmation supplémentaire dépenses.

D'autres raisons de choisir un TPU incluent le fait que le G de VRAM du v3-128 8 dépasse celui de GPU Nvidia, faisant de la v3-8 une meilleure alternative pour le traitement de grands ensembles de données associés à NLU et PNL.

Des vitesses plus élevées peuvent également conduire à une itération plus rapide pendant les cycles de développement, conduisant à une innovation plus rapide et plus fréquente, augmentant ainsi les chances de succès sur le marché.

Le TPU surpasse le GPU en termes de vitesse d'innovation, de facilité d'utilisation et d'abordabilité; les consommateurs et les architectes cloud doivent tenir compte du TPU dans leurs initiatives de ML et d'IA.

Le TPU de Google a une grande capacité de traitement et l'utilisateur doit coordonner la saisie des données pour s'assurer qu'il n'y a pas de surcharge.

Voilà, un total de TPU vs. Comparaison GPU. Nous aimerions connaître votre opinion et voir si vous avez effectué des tests et quels résultats vous avez reçus sur le TPU et le GPU.

N'oubliez pas que vous pouvez profiter d'une expérience PC immersive en utilisant l'un des meilleures cartes graphiques pour Windows 11.

Vous avez toujours des problèmes ?Corrigez-les avec cet outil :

Vous avez toujours des problèmes ?Corrigez-les avec cet outil :

- Téléchargez cet outil de réparation de PC noté Excellent sur TrustPilot.com (le téléchargement commence sur cette page).

- Cliquez sur Lancer l'analyse pour trouver les problèmes Windows qui pourraient causer des problèmes au PC.

- Cliquez sur Tout réparer pour résoudre les problèmes avec les technologies brevetées (Remise exclusive pour nos lecteurs).

Restoro a été téléchargé par 0 lecteurs ce mois-ci.

![Meilleur support de support GPU [Sur les 5 les plus populaires en ce moment]](/f/af48cf184041eeae23a5b21755ff29ab.png?width=300&height=460)

![5 façons de réparer le GPU s'il est à 0 % d'utilisation [In Idle, Gaming]](/f/92e7d57121e8099f0896dd03a7afeacf.png?width=300&height=460)