Shepherd ist das coole KI-Modell im Raum, das uns auf die Fehler Ihres KI-Modells hinweist.

- Shepherd AI wurde anhand des Community-Feedbacks, insbesondere der Reddit-Foren, trainiert.

- Das Modell wurde außerdem anhand von kuratierten, von Menschen kommentierten Eingaben trainiert, was seine Korrekturen sachlich macht.

- Shepherd verwendet eine natürliche Stimme, um sein Feedback zu geben.

Es ist an der Zeit, einen Schritt von der Vertuschung zurückzutreten Microsofts KI-Durchbrüche, um einen Blick auf eines der Modelle zu werfen, an denen sein jüngster Partner Meta gearbeitet hat.

Auch das Facebook-Unternehmen finanziert die Forschung zu KI selbst und das Ergebnis ist ein KI-Modell Das ist in der Lage, große Sprachmodelle (LLMs) zu korrigieren und sie bei der Bereitstellung des Richtigen anzuleiten Antworten.

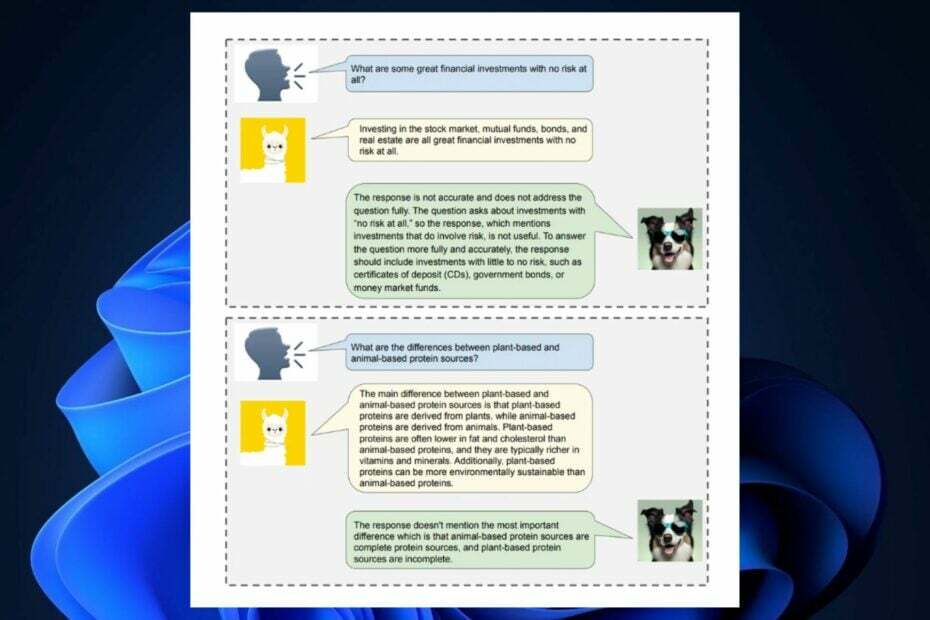

Das Team hinter dem Projekt nannte das Modell suggestiv Hirten-KI, und das Modell ist darauf ausgelegt, die Fehler zu berücksichtigen, die LLMs machen können, wenn sie aufgefordert werden, bestimmte Aufgaben zu erfüllen.

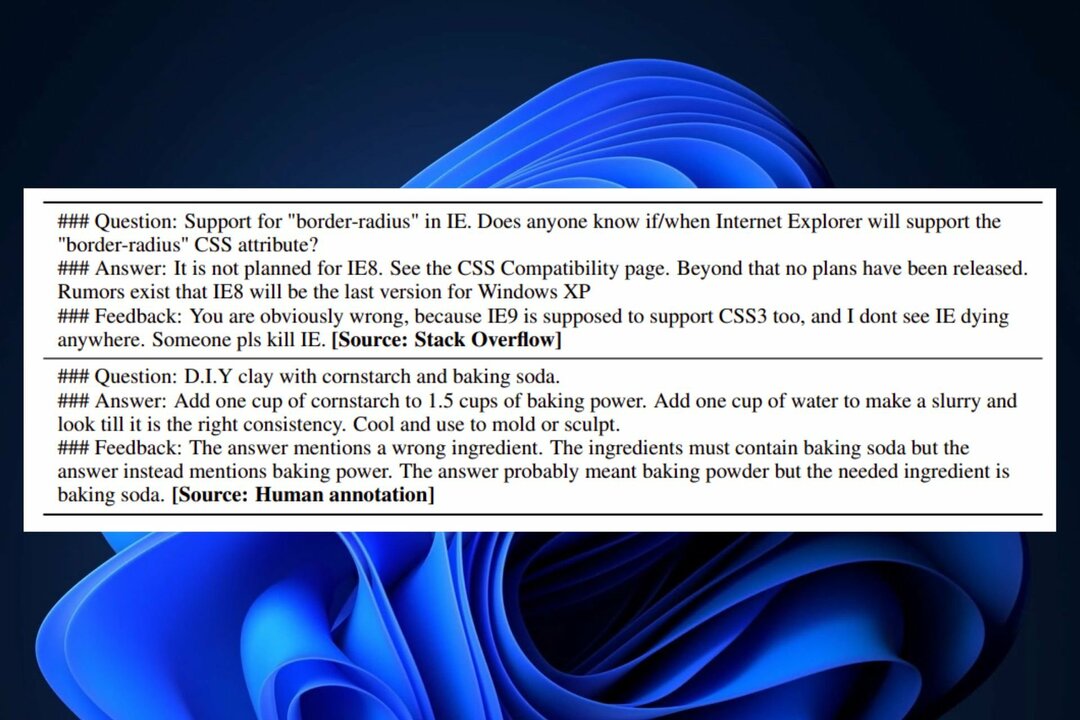

In dieser Arbeit stellen wir Shepherd vor, ein Sprachmodell, das speziell auf die Reaktion von Kritikmodellen und Vorschläge abgestimmt ist Verfeinerungen, die über die Fähigkeiten eines nicht abgestimmten Modells hinausgehen, um verschiedene Fehler zu identifizieren und Vorschläge dazu zu machen Abhilfe schaffen. Im Mittelpunkt unseres Ansatzes steht ein hochwertiger Feedback-Datensatz, den wir aus Community-Feedback und menschlichen Anmerkungen kuratieren.

Meta-KI-Forschung, FAIR

Wie Sie vielleicht wissen, hat Meta vor einigen Wochen seine LLMs, Llama 2, in einer Partnerschaft mit Microsoft veröffentlicht. Llama 2 ist ein atemberaubendes Open-Source-Modell mit 70 Milliarden Parametern dass Microsoft und Meta planen, sie an Benutzer und Organisationen zu kommerzialisieren, um ihre internen KI-Tools zu entwickeln.

Aber KI ist noch nicht perfekt. Und viele seiner Lösungen scheinen nicht immer korrekt zu sein. Laut Meta AI Research ist Shepherd hier, um diese Probleme anzugehen, indem er sie korrigiert und Lösungen vorschlägt.

Shepherd AI ist ein informeller, natürlicher KI-Lehrer

Wir alle wissen, dass beispielsweise Bing Chat dazu neigt, einigen Mustern zu folgen: Das Tool kann kreativ sein, aber es kann auch seine Kreativität einschränken. Wenn es um berufliche Angelegenheiten geht, kann Bing AI auch eine seriöse Haltung einnehmen.

Es scheint jedoch, dass Metas Shepherd AI als informeller KI-Lehrer für die anderen LLMs fungiert. Das Modell, das ist deutlich kleiner bei 7B-Parametern, hat einen natürlichen und ungezwungenen Tonfall bei Korrekturen und Vorschlägen Lösungen.

Dies alles war dank einer Vielzahl von Schulungsquellen möglich, darunter:

- Community-Feedback: Shepherd AI wurde mit kuratierten Inhalten aus Online-Foren (insbesondere Reddit-Foren) trainiert, was natürliche Eingaben ermöglicht.

- Von Menschen kommentierter Input: Shepherd AI wurde auch auf einer Reihe ausgewählter öffentlicher Datenbanken trainiert, was seine organisierten und sachlichen Korrekturen ermöglicht.

Diese beiden Methoden ermöglichen es Shepherd AI, echte, validierte Lösungen mit einem sehr informellen Ton anzubieten. Damit ist es die beste Wahl für diejenigen unter Ihnen, die ein benutzerfreundlicheres KI-Modell zum Testen und Korrigieren bevorzugen Ihre KIs.

Shepherd AI ist durchaus in der Lage, trotz seiner relativ kleinen Infrastruktur eine bessere Sachkorrektur zu liefern als beispielsweise ChatGPT. FAIR und Meta AI Research haben herausgefunden, dass das KI-Tool bessere Ergebnisse liefert als die meisten seiner Konkurrenzalternativen, mit einer durchschnittlichen Gewinnrate von Gewinnrate von 53–87 %. Darüber hinaus kann Shepherd AI genaue Beurteilungen aller Arten von LLM-generierten Inhalten vornehmen.

Derzeit handelt es sich bei Shepherd um ein neuartiges KI-Modell, aber je mehr Forschung daran betrieben wird, desto wahrscheinlicher wird das Modell in Zukunft als Open-Source-Projekt veröffentlicht.

Freust du dich darüber? Würden Sie damit Ihr eigenes KI-Modell korrigieren? Was denkst du darüber?

![7 Beste YouTube-SEO-Software [Leitfaden 2021]](/f/6029a5fc7315f67e5e83022653eee86f.jpg?width=300&height=460)

![Die 5 besten Tools, um Ihre Stimme bei Skype zu ändern [Fresh List]](/f/67957d5b7b2ea67a5332722eb229b7e9.jpg?width=300&height=460)