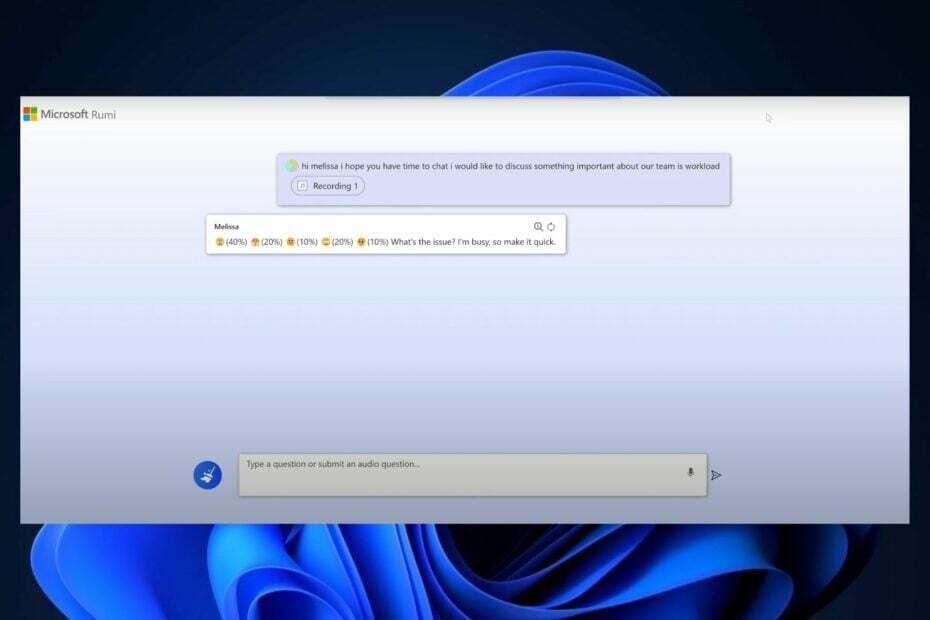

Projekt Rumi er i stand til menneskelignende svar.

- Project Rumi integrerer dine fysiske udtryk for at danne en mening om dine input.

- AI-sproget vil reagere på dig i henhold til din holdning.

- Project Rumi er et AI-gennembrud, da det giver AI-modeller mulighed for at være menneskelignende.

Microsoft har investeret mange ressourcer i AI-forskning i løbet af de seneste måneder: LongMem, som tilbyder ubegrænset kontekstlængde, og Kosmos-2, som visualiserer rumlige begreber, og det kommer med sit eget input om dem. Så har du Orca 13B, som er open source, så du kan træne dine AI-modeller.

Der er også phi-1, som er meget i stand til at lære komplekse blokke af Python. Og Microsoft har endda støttet forskningen i kreativ AI, såsom DeepRapper, hvilket er, ja, du gættede rigtigt, en AI-rapper.

Den Redmond-baserede teknologigigant er foran kurven, når det kommer til AI. Det annoncerede for nylig et partnerskab med Meta, at udvikle Llama 2, som er en LLM, der har 70 milliarder parametre, nogle af de hidtil mest.

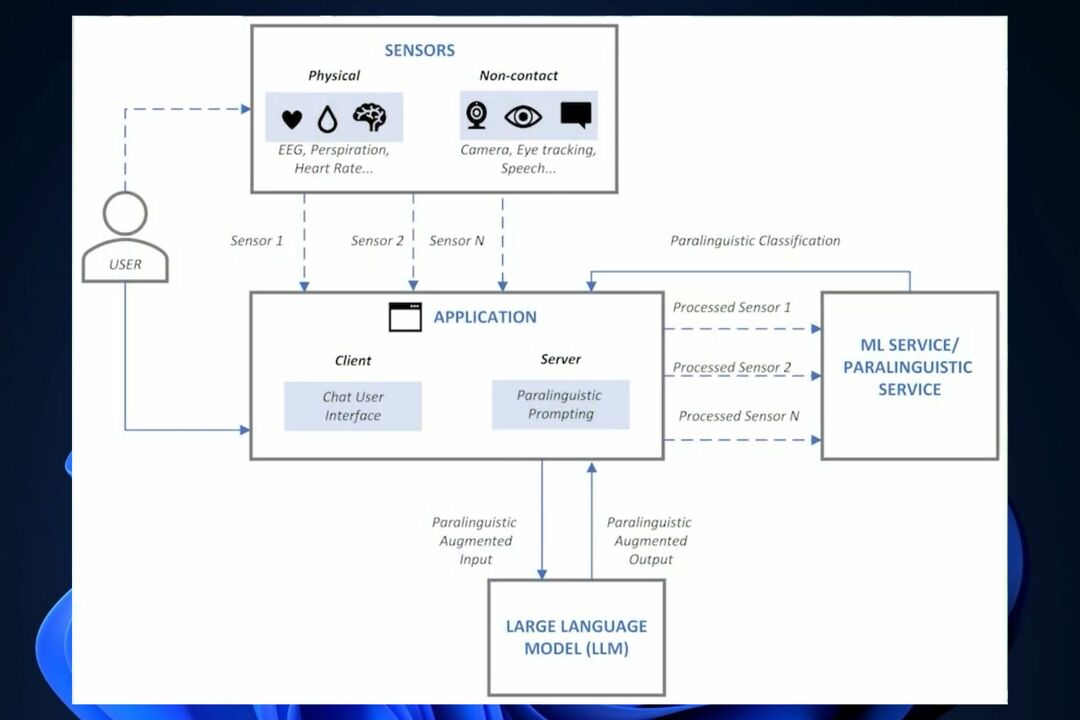

Og nu ser det ud til, at Microsoft også investerer i Projekt Rumi, en AI-model, som er i stand til at inkorporere paralingvistisk input i sine interaktioner. Dette er et gennembrud inden for kunstig intelligens, og det vil bringe andre modeller tættere på at opnå et menneskelignende responssystem.

Hvad er Microsoft Project Rumi?

Microsoft Project Rumi er en stor sprogmodel, der er i stand til at integrere alle dine fysiske udtryk for at danne en mening om din holdning og derefter svare dig i overensstemmelse hermed. Det betyder, at hvis du bliver vred, vil modellen faktisk læse dit ansigtsudtryk, og den vil lytte til din stemmetone.

Og så vil det danne et svar, der går efter din holdning.

Project Rumi gør dette ved at få adgang til din mikrofon og webkamera, og det vil faktisk optage dit ansigt for at give mening med fysiske udtryk.

Project Rumi er patenteret af Microsoft i et forsøg på at adressere de nuværende AI-modellers begrænsninger, når det kommer til deres input. For eksempel kan Bing AI ikke se dine ansigtsudtryk, og den kan ikke høre din stemmetone, når du beder den om at gøre noget. Som en konsekvens vil svaret være noget kunstigt og ikke-menneskeligt.

Microsoft Project Rumi kommer og adresserer disse begrænsninger ved at gøre brug af eksisterende tekniske muligheder for at fange dine menneskelige udtryk. Til gengæld lærer Project Rumi menneskelige udtryk og bygger sin adfærd ud fra dem.

Da Project Rumi er en LLM, vil modellen blive brugt til at træne andre AI-modeller. Så du vil snart være i stand til at interagere med en menneskelignende AI. Lyder det fedt eller ej? Hvad synes du?