Gaming er ved at blive meget mere ægte

- Gaming på Windows er ved at blive mere og mere sjovt og interaktivt.

- NVIDIA præsenterede ACE under en nylig keynote, hvor der blev afsløret.

- Ved hjælp af denne nye teknologi kan NPC'er tale med spillerfigurer i realtid.

Du ved det måske nu endnu, men under gårsdagens hovedtale på Computex i Taiwan viste NVIDIAs administrerende direktør, Jensen Huang, en ny teknologi for spiludviklere.

Og ja, denne nye teknologi involverer brug af AI og cloud-servere, hvilket er blevet virksomhedens store nye fokus.

Uden at ødelægge noget endnu, skal du bare vide, at denne nye teknologi faktisk vil gøre brug af Microsofts Chat GPT og Googles BARD AI software.

NPC-interaktioner vil blive mere og mere reelle

Denne nye teknologi kaldes NVIDIA ACE (Avatar Cloud Engine) til spil. Det er ikke det korteste af navne, som navne går, men du kan bare bruge akronymet.

I virkeligheden vil det give udviklere mulighed for at indsætte NPC'er, der kan tale med spillerkarakterer i realtid, men med dialog, der er ikke-scriptet og drevet af AI-chatbots, der ligner ChatGPT, Bing Chat og Bard.

Ydermere vil du også få lov til, at NPC-ansigtsanimationerne matcher den ikke-scriptede dialog. Hvordan er det for nogle 2023-teknologier?

Med den kan du bringe liv til NPC'er gennem NeMo-modeljusteringsteknikker. Anvend først adfærdskloning for at gøre det muligt for basissprogmodellen at udføre rollespilsopgaver i henhold til instruktionerne.

For yderligere at afstemme NPC's adfærd med forventningerne kan du i fremtiden anvende forstærkning læring fra menneskelig feedback (RLHF) for at modtage feedback i realtid fra designere under udviklingen behandle.

Virksomheden udtalte også, at disse AI NPC'er styres af NeMo Guardrails, hvilket forhåbentlig vil forhindre dem i at sige mærkelige eller endda stødende ting til spillere.

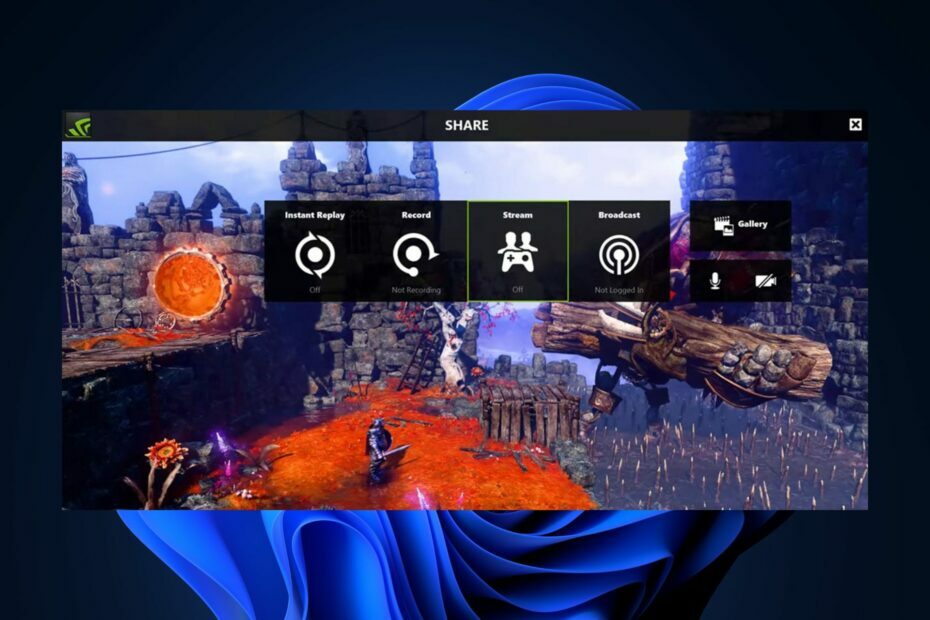

Som du kan se ovenfor, viste NVIDIA en kort demo af ACE, der blev lagt ud på YouTube. Det blev skabt i Unreal Engine 5 med ray tracing aktiveret og MetaHuman-teknologi til NPC-karaktermodeller.

NVIDIA brugte også teknologi fra et startup-firma kaldet Convai, der skaber AI-karakterer i spil.

Husk, at Convai brugte NVIDIA Riva til tale-til-tekst og tekst-til-tale-funktioner, NVIDIA NeMo for LLM, der driver samtalen, og Audio2Face til AI-drevet ansigtsanimation fra stemme input.

AI NPC vist i demoen er bestemt ikke perfekt. Hans talemønster virkede meget opstyltet og, tør vi sige, kunstigt af natur.

Når det er sagt, er det mere end sandsynligt, at talemønstre vil blive forbedret og blive mere naturligt i de kommende måneder og år.

NVIDIA oplyste dog ikke, hvornår ACE for Games vil være tilgængelig for spiludviklere, så lad os ikke komme os selv for langt.

Audio2Face-teknologi, som matcher ansigtsanimationen til en spilfigurs tale, bliver brugt i to kommende spil: tredjepersons sci-fi-spillet Fort Solis, og den længe ventede post-apokalyptiske FPS-efterfølger FORFØLGER. 2: Heart of Chornobyl.

Hvad er dine tanker om denne seneste nyhed fra NVIDIA? Del dine meninger med os i kommentarfeltet nedenfor.